「GPT‑4o mini」とは?低価格で活用できる最新ミニモデルを徹底解説

生成AIを業務や日常で活用する際、「高機能なモデルはコストが気になる」「もっと手軽に使える選択肢はないか」と悩む方も多いのではないでしょうか。そんな中登場したのが、低価格でありながら高いパフォーマンスを発揮する最新の軽量モデル「GPT-4o mini」です。

しかし、GPT-4o miniの活用に関心を持つ方の中には、次のような疑問や懸念をお持ちではないでしょうか。

GPT-4o miniの特長や性能について知りたい

どのような用途に適しているのか?

GPT-4o mini 利用時の注意点について知りたい

そこでこの記事では、GPT-4o miniの概要から具体的な活用シーン、さらにはプロンプトの工夫までを徹底解説します。

この記事を読めば、GPT-4o miniの魅力や活用法を体系的に理解し、自分の目的に合わせて効果的に使いこなせるようになります。

ぜひ参考にしてください。

ChatGPTの特徴をより詳しく知りたい人は、次の記事を参考にしてください。

なお、生成AIを学び副業や業務効率化を実現したい人は「侍エンジニア」をお試しください。

侍エンジニアでは現役エンジニアと学習コーチが学習をサポート。AIプログラミングやPython・VBAの習得を通じて、手間のかかる作業を効率化する方法を学べます。

受講料が最大80%OFFになる「給付金コース」も提供中。未経験から挫折なくAIスキルを習得したい人は、ぜひ一度お試しください。

GPT-4o miniとは何か?

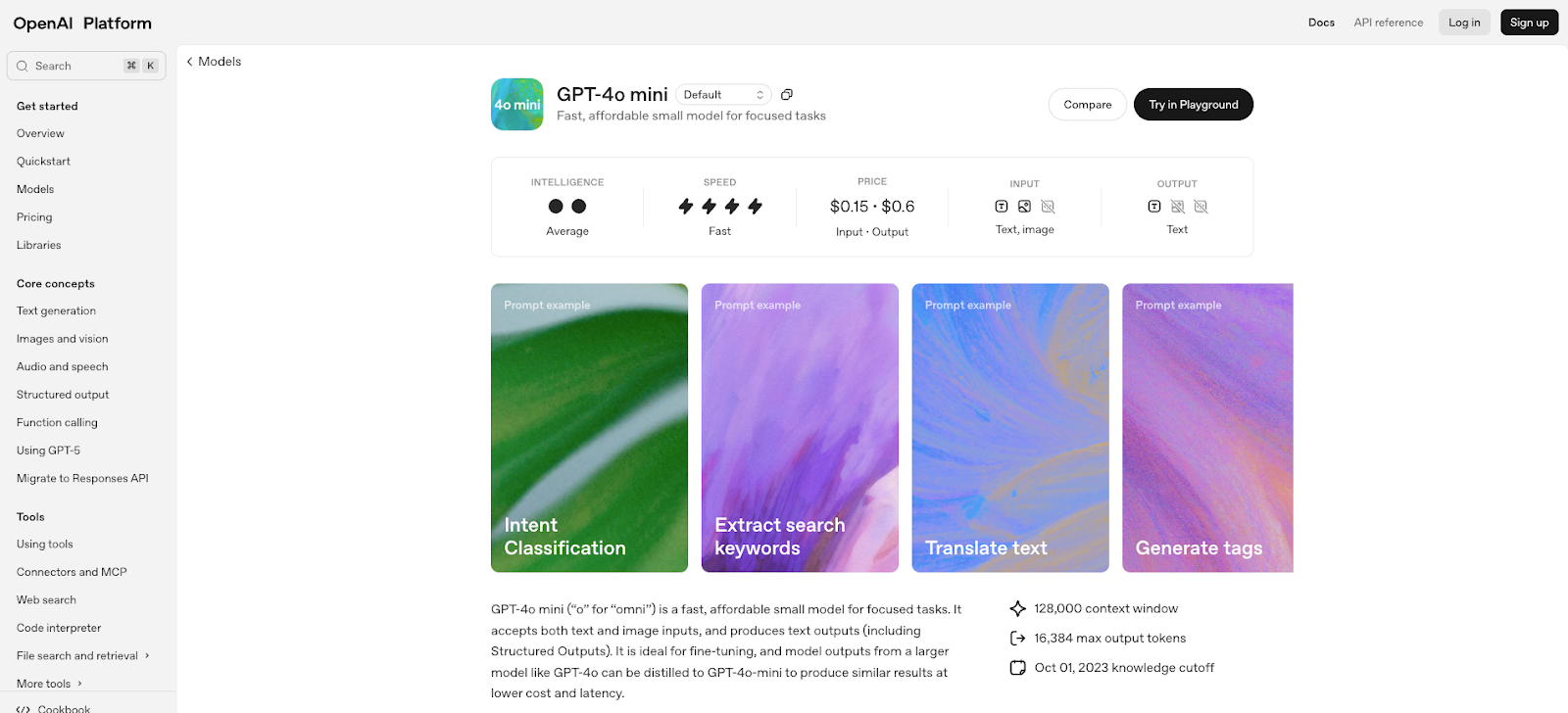

GPT‑4o miniは、OpenAIが2024年7月18日に発表した費用効率が非常に高い小型モデルです。

APIで現在利用できる最もコスト効率に優れたモデルとして、開発者がより多様なアプリケーションを手軽に構築できることを目指しています。

同モデルは、MMLUにおいて82%という高得点を記録し、LMSYSリーダーボード上ではチャットの好み評価においてGPT‑4に勝るというパフォーマンスを示しました。

テキスト知能やマルチモーダルの推論性能も優れており、数学的推論(MGSM 87.0%)、コーディング(HumanEval 87.2%)、マルチモーダル推論(MMMU 59.4%)などの主要ベンチマークでも他の小型モデルを上回る結果を達成しています。

さらに、GPT‑4oと共通の改良されたトークナイザーを活用しており、特に非英語テキストの処理におけるコスト効率が向上しています。

GPT‑4oとの違い

GPT‑4o miniとGPT‑4oの主な違いは、モデルのサイズ・性能とコスト効率にあります。

GPT‑4oは、テキスト・音声・画像・映像を含むマルチモーダルな入出力に対応し、リアルタイムでの処理も可能とする旗舰モデルです。

一方、GPT‑4o miniはより軽量かつ安価でありながら、MMLU、MGSM、HumanEval、MMMUなどの学術ベンチマークで他の小型モデルより高いパフォーマンスを発揮しますが、GPT‑4oほど広範なマルチモーダル出力能力やリアルタイム処理性能は持ちません。

つまり、GPT‑4oは高性能・多機能・多用途の旗舰モデルであるのに対し、GPT‑4o miniは「必要な能力をおさえつつ、低コスト・高速レスポンスを重視」したモデルであり、開発者の用途やコスト優先のプロジェクトに適しています。

GPT-4oの特徴をより詳しく知りたい人は、次の記事を参考にしてください。

GPT-4o mini料金体系

GPT‑4o miniは、その費用効率の高さが最大の特徴です。

開発者向けAPIでは、入力トークンにつき100万トークン = 0.15ドル(15セント)、出力トークン側は100万トークン = 0.60ドル(60セント)という価格設定になっています。

APIではAssistants、Chat Completions、Batchの各種インターフェースで利用可能で、将来的にはファインチューニングもサポートされる予定です。

また、ChatGPTプラットフォームでは、Free/Plus/TeamユーザーがGPT‑3.5の代わりにGPT‑4o miniにアクセスでき、Enterpriseユーザーにも順次開放する予定です。

| トークンタイプ | 価格(1百万トークンあたり) |

|---|---|

| 入力トークン(Input) | $0.15(0.15ドル) |

| 出力トークン(Output) | $0.60(0.60ドル) |

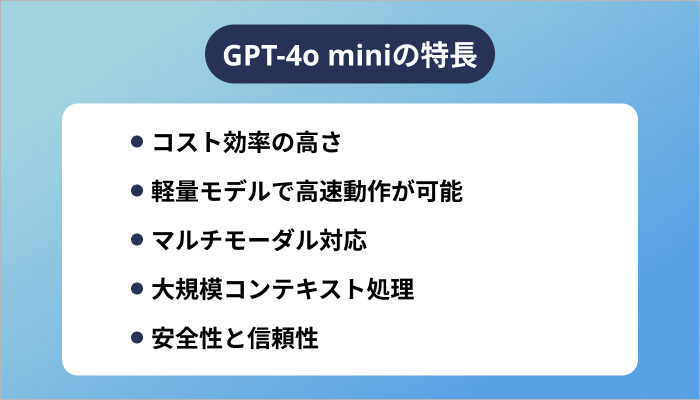

GPT-4o miniの特長

GPT-4o miniは、OpenAIが2024年に発表した最新の軽量モデルで、コスト効率と高性能を両立した点が最大の特長です。

従来のフラッグシップモデルであるGPT-4oと比較すると、機能や表現力は一部抑えられているものの、その分大幅に低価格で提供され、より多くのユーザーや開発者が使いやすい設計になっています。

本章では、GPT-4o miniの代表的な5つの特長について詳しく解説していきます。

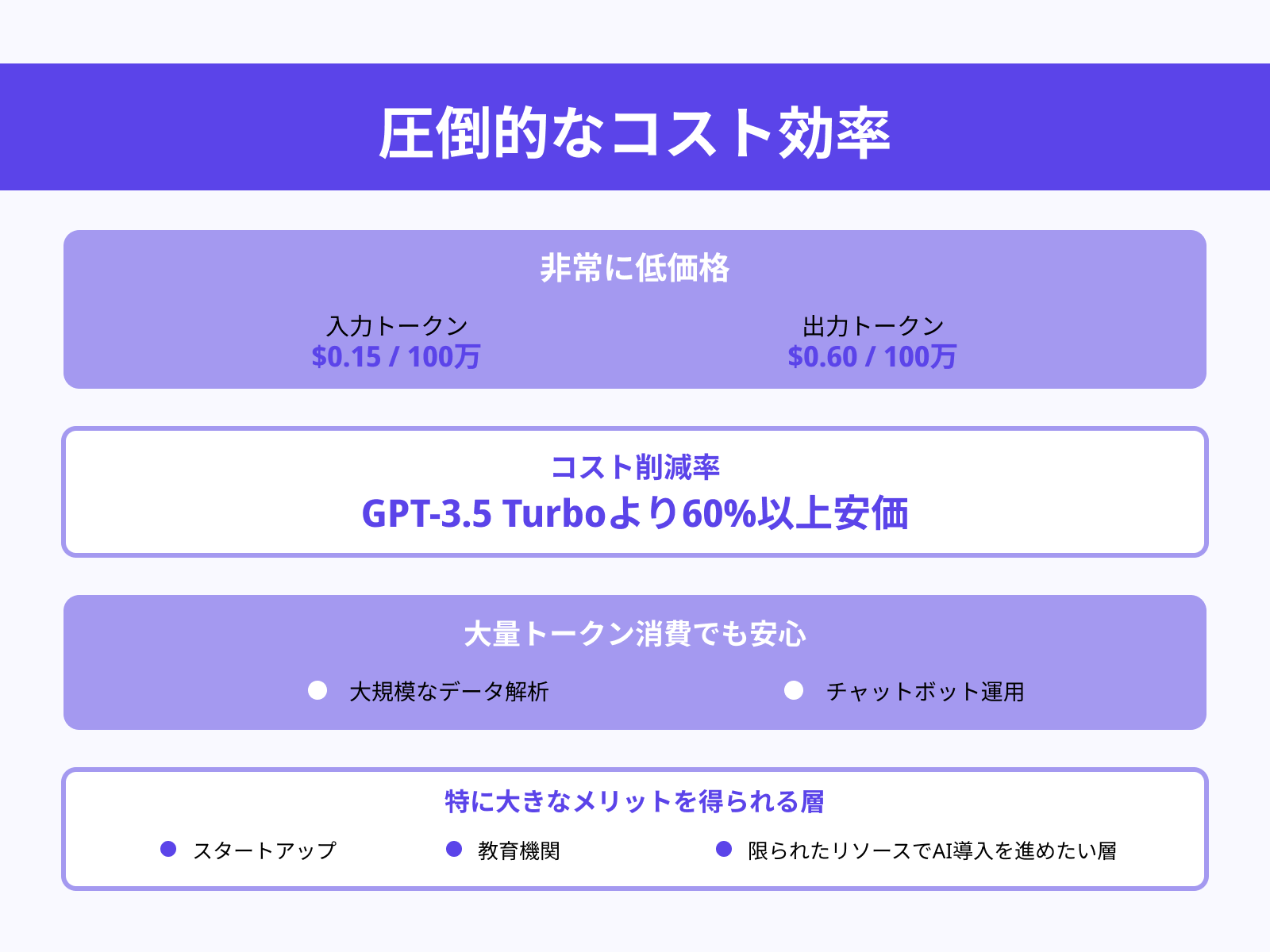

コスト効率の高さ

GPT-4o miniの最大の魅力は、圧倒的なコスト効率にあります。API利用時の価格は入力トークン100万あたり0.15ドル、出力トークン100万あたり0.60ドルと非常に低価格です。

これはGPT-3.5 Turboより60%以上安価であり、さらに旧世代の高性能モデルと比べると桁違いにコストを削減できます。

たとえば、大規模なデータ解析やチャットボット運用のように、大量のトークンを消費する場面でも安心して活用できるため、開発者や企業にとって導入ハードルが大幅に下がります。

コストを抑えつつ高度なAIを利用できる点は、スタートアップや教育機関など、限られたリソースでAI導入を進めたい層にとって特に大きなメリットといえるでしょう。

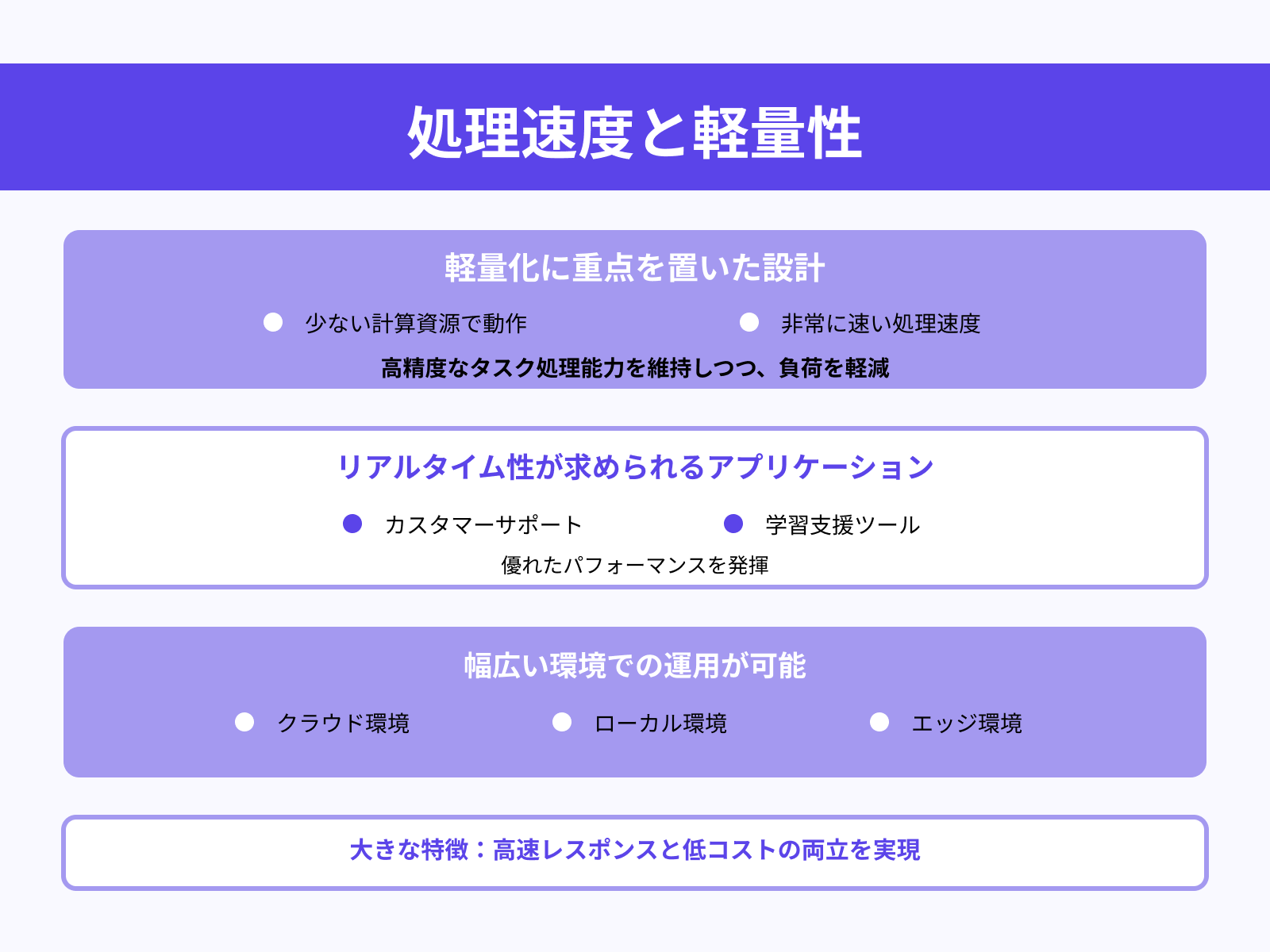

軽量モデルで高速動作が可能

GPT-4o miniは「軽量化」に重点を置いた設計がなされており、少ない計算資源で動作可能です。

これにより処理速度が非常に速く、応答時間を短縮できるのが大きな利点です。

高精度なタスク処理能力を維持しつつ、負荷が軽減されているため、リアルタイム性が求められるアプリケーションで優れたパフォーマンスを発揮します。(例えばカスタマーサポートや学習支援ツールなど)さらに、クラウド利用時だけでなくローカル環境やエッジ環境での運用にも適しており、幅広い場面で「すぐに使えるAI」として実装しやすい設計です。

従来の重量級モデルでは難しかった「高速レスポンスかつ低コスト」の両立を実現した点が、GPT-4o miniの大きな特徴です。

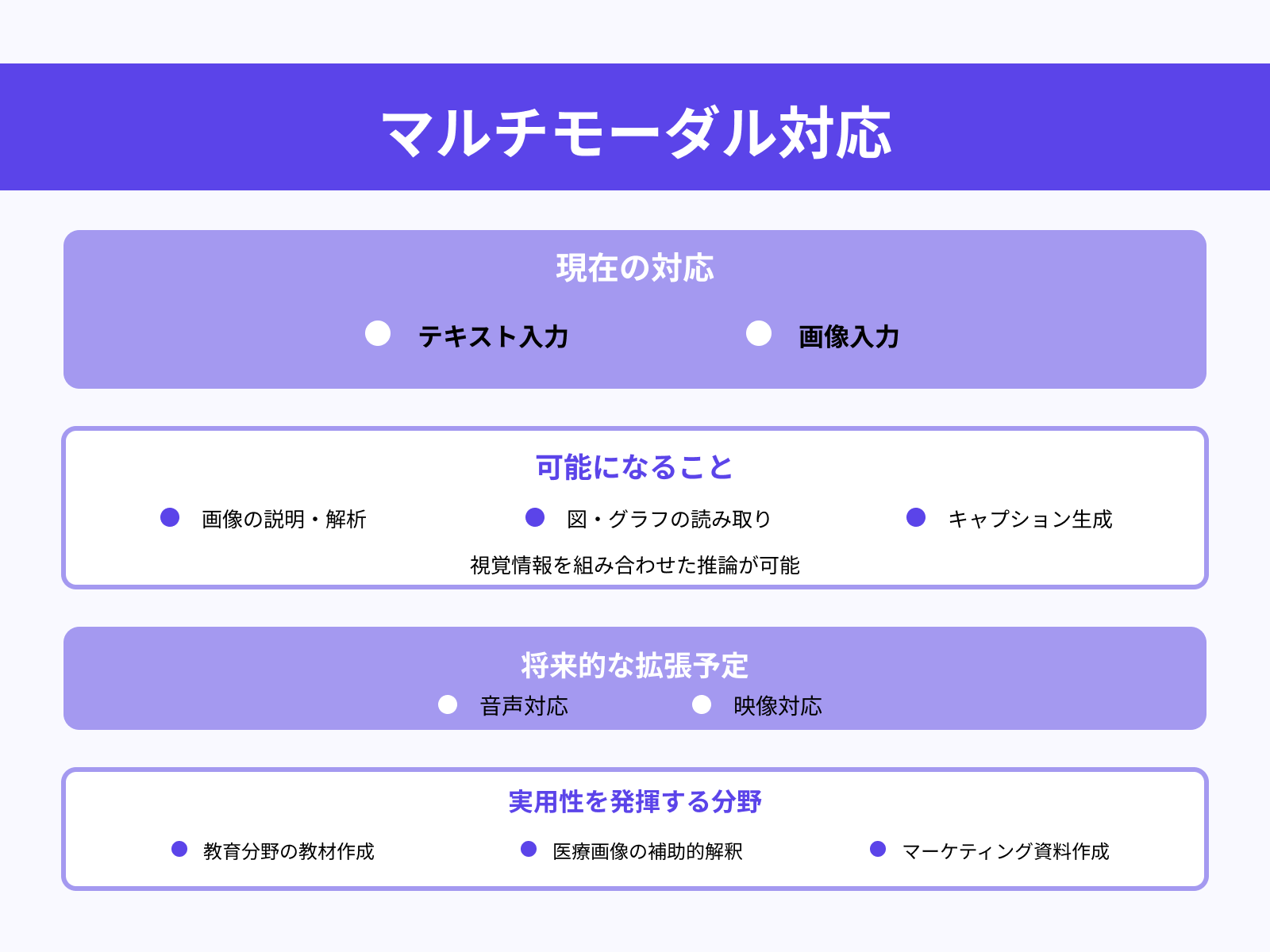

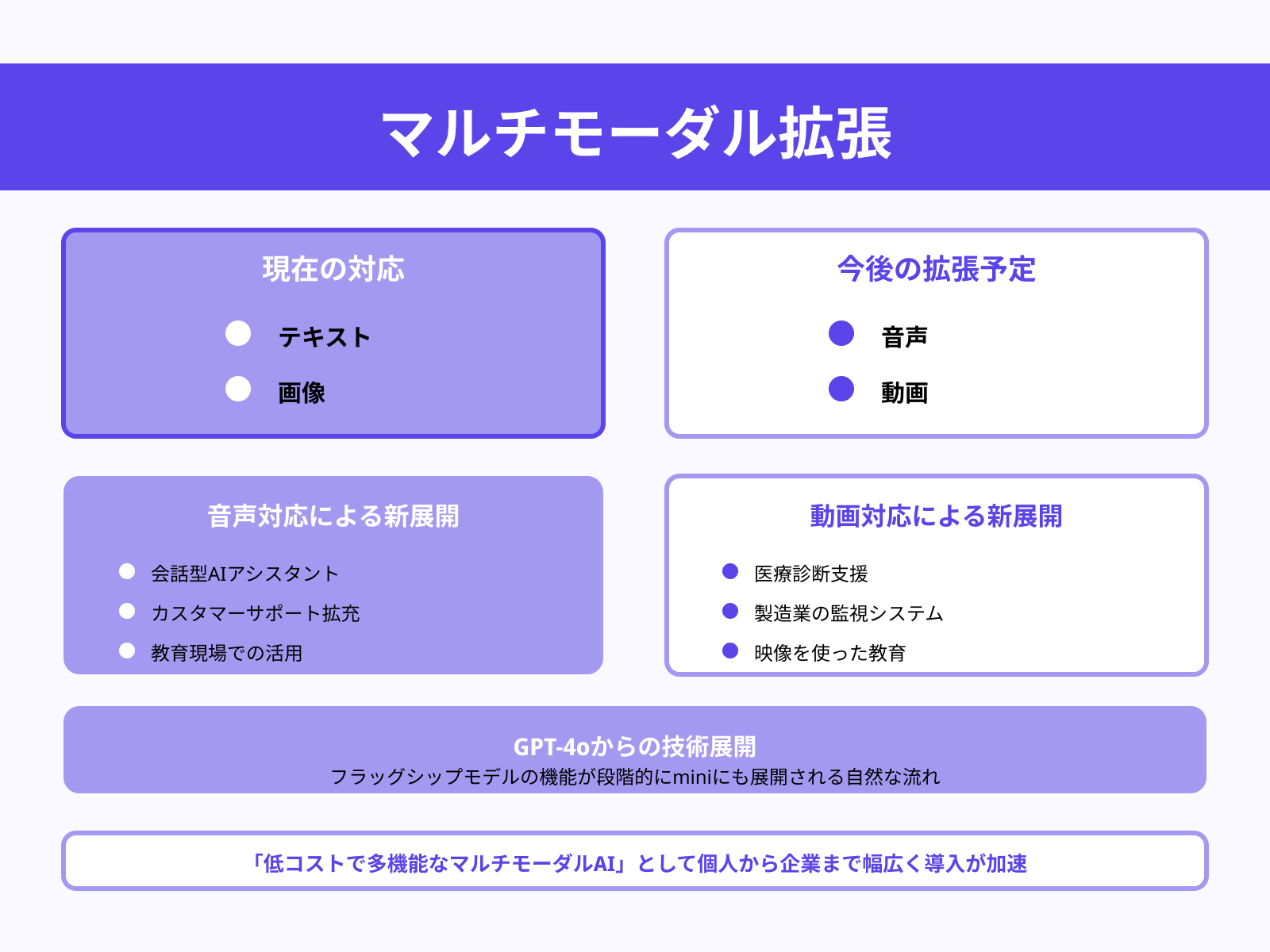

マルチモーダル対応

GPT-4o miniはテキスト入力に加えて画像入力にも対応するマルチモーダルモデルです。

これにより、文章の理解だけでなく、画像の説明や解析、視覚情報を組み合わせた推論が可能になります。例えば、図やグラフを読み取って解説したり、写真をもとにキャプションを生成するなど、多様な応用が期待できます。

現時点ではテキストと画像に焦点が当てられていますが、将来的には音声や映像にも対応が拡張される予定であり、より幅広い活用が可能になります。

マルチモーダル対応は、教育分野の教材作成、医療画像の補助的解釈、マーケティング資料の作成など、幅広い分野で実用性を発揮するでしょう。こうした汎用性の高さが、GPT-4o miniを「次世代の小型AIモデル」として際立たせています。

大規模コンテキスト処理

GPT-4o miniは、128,000トークン(128K)のコンテキストウィンドウを備えており、一度に大量の文脈を読み込んで処理できます。

これは膨大な会話履歴や長文データを保持しながら、自然な応答や正確な要約を生成できることを意味します。さらに、最大16,000トークンの出力も可能なため、大規模レポートや記事生成といった長文タスクに適しています。

この規模のコンテキスト処理能力は、研究者が学術論文をまとめる際や企業が長大な契約書を解析する際など、従来では困難だった作業を効率化します。

特に情報量が多く複雑なプロジェクト管理や知識整理において強力な武器となり、ビジネスでもアカデミック分野でも幅広く活用可能です。

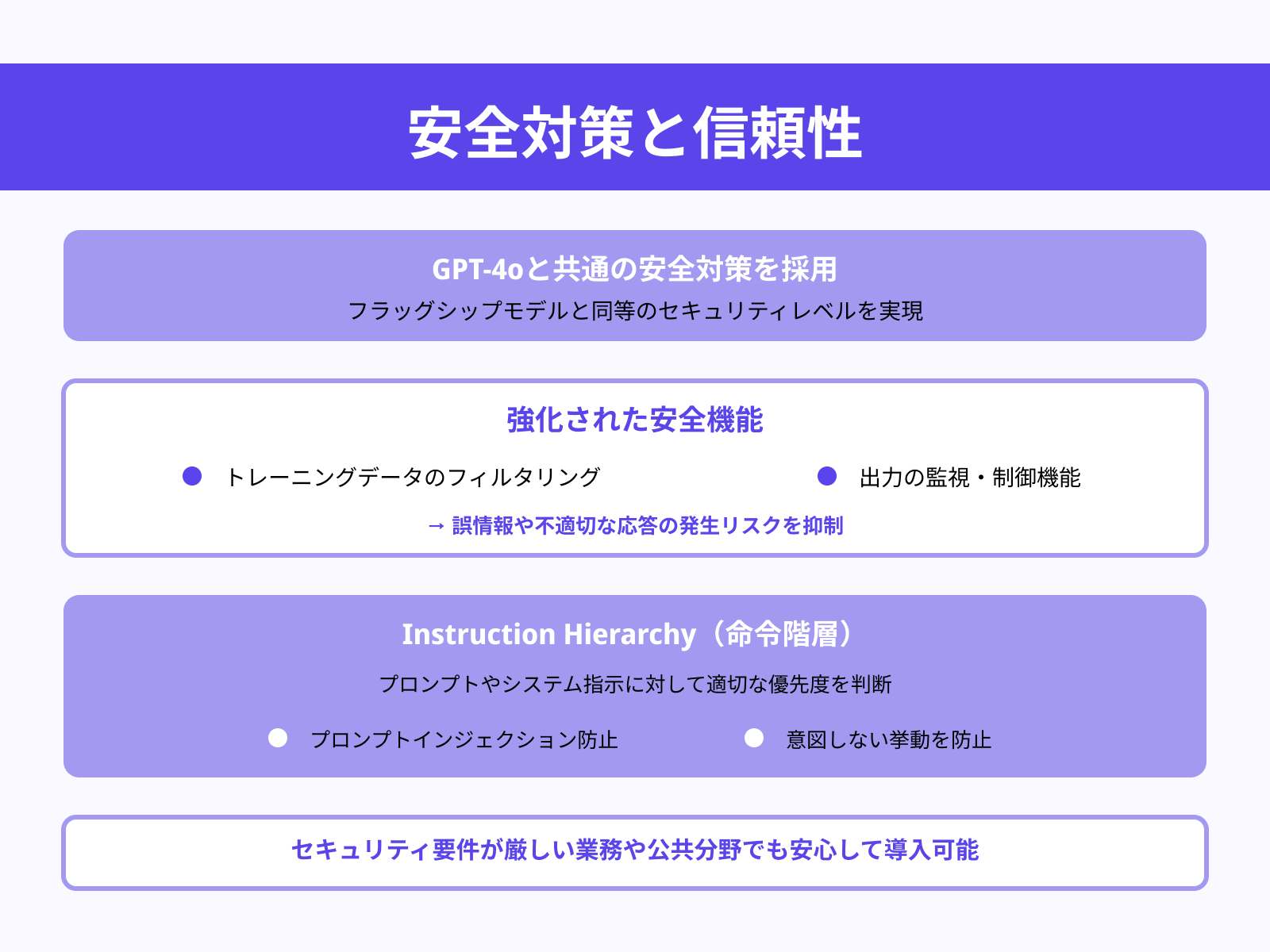

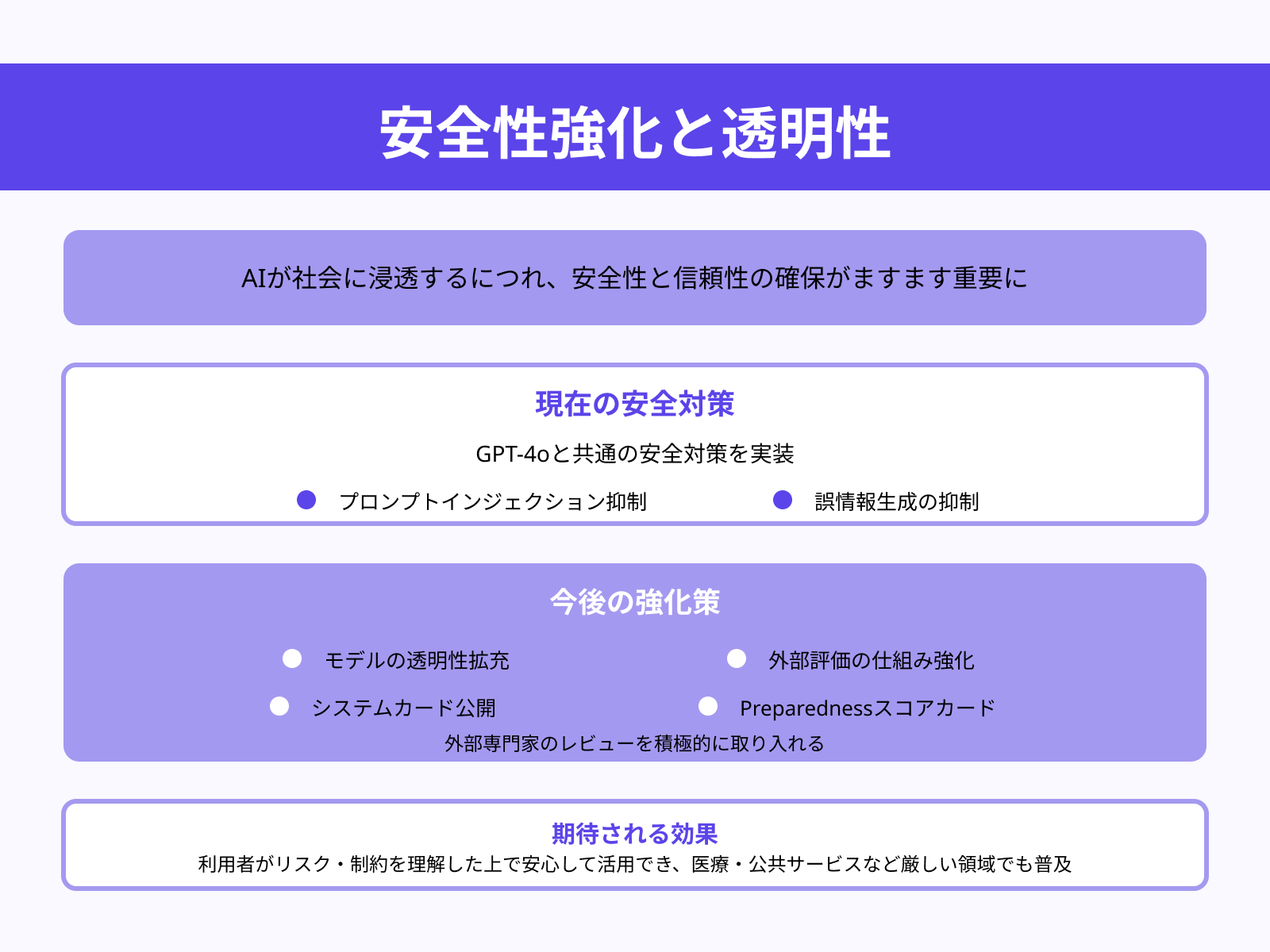

安全性と信頼性

GPT-4o miniは、フラッグシップモデルGPT-4oと共通の安全対策を採用しています。

具体的には、トレーニングデータのフィルタリングや出力の監視・制御機能が強化されており、誤情報や不適切な応答の発生リスクを抑制します。

また「instruction hierarchy」と呼ばれる仕組みを導入し、プロンプトやシステム指示に対して適切な優先度を判断することで、不正なプロンプトインジェクションや意図しない挙動を防ぎます。これにより、セキュリティ要件が厳しい業務や公共分野でも安心して導入できる信頼性を実現しました。

ユーザーや開発者は、AI活用によるリスクを最小限に抑えつつ、安定した運用が可能になります。

GPT-4o mini の性能(ベンチマーク)

GPT‑4o mini は、学術ベンチマークにおいて非常に高い性能を示し、同クラスの小型モデルを上回ることが特徴です。

まず、テキスト知能に関するMMLUでは82.0%と、Gemini Flash(77.9%)やClaude Haiku(73.8%)を上回ります。数学的推論を測るMGSMでは87.0%、コード生成(HumanEval)でも87.2%という高得点を記録し、いずれも競合モデルを大きくリードしています。

さらに、マルチモーダル推論性能も59.4%と堅実な結果で、視覚とテキストの統合的理解でも優れた能力を発揮しています。また、LMSYS leaderboard によれば、GPT‑4o mini は131モデル中で4位にランクインしており、人間によるペア比較評価でも高い評価を得ています。

これらのデータから、軽量ながらも学術・実用の両面で高度な性能を兼ね備えたモデルであることが分かります。

ChatGPT-4o mini の3つの活用方法

ChatGPT-4o mini は、OpenAI が提供する軽量かつ低コストな最新モデルで、幅広いユースケースに対応できる万能型AIです。高速処理と高い文脈理解力を兼ね備え、開発者だけでなく教育現場やカスタマーサポートなど多様な領域で実用可能です。

ここでは、ChatGPT-4o mini の代表的な活用方法として「カスタマーサポート・FAQ対応」「教育・学習支援」「コーディング支援」の3つを紹介します。

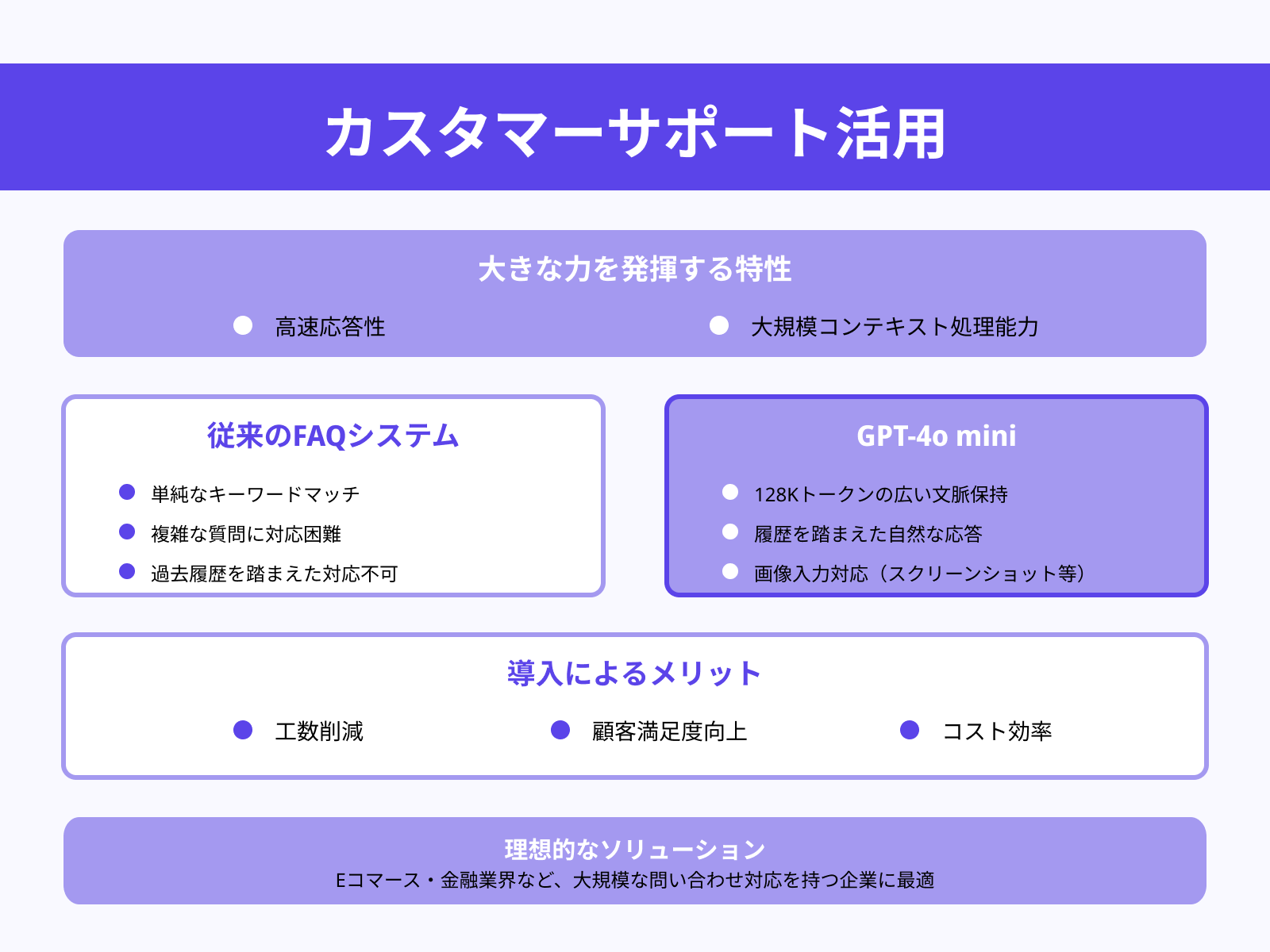

カスタマーサポート・FAQ対応

カスタマーサポート分野では、GPT-4o mini の高速応答性と大規模コンテキスト処理能力が大きな力を発揮します。

従来のFAQシステムは単純なキーワードマッチが中心で、複雑な質問や過去履歴を踏まえた対応は困難でした。

しかし GPT-4o mini であれば、128Kトークンという広い文脈を保持し、問い合わせの履歴を踏まえた自然な応答が可能です。さらに、画像入力に対応しているため、スクリーンショットや写真を送って問い合わせできるケースにも対応可能です。

これにより、Eコマースや金融業界のカスタマーサポートに導入すれば、工数削減と顧客満足度向上を同時に実現できます。コスト効率が高いため、大規模な問い合わせ対応を持つ企業にとっても理想的なソリューションとなります。

教育・学習支援(パーソナルチューター)

教育分野では、GPT-4o mini が「パーソナルチューター」として学習を支援する役割を果たします。

従来のAI学習支援ツールは短い応答や基本的な解説にとどまることが多かったですが、本モデルは長大な文脈を処理できるため、教科書丸ごとの内容や過去の質問履歴を踏まえた対話が可能です。

例えば、数学の問題を解くプロセスを段階的に解説したり、歴史の授業で背景知識を補足するなど、生徒ごとにカスタマイズされた回答を提示できます。さらに、画像入力を組み合わせることで、グラフや図表を用いた学習支援も可能になります。

コスト効率が高いため、教育機関やオンライン学習サービスで大規模導入しやすく、学習の質を底上げしつつ負担を軽減できます。生徒は「質問すればすぐに答えてくれる個別教師」としてGPT-4o miniを利用できるため、学習効率が大幅に向上するでしょう。

開発者向けコーディング支援

GPT-4o mini は、開発者にとっても強力なアシスタントになります。

HumanEval におけるスコアは 87.2% と高く、コード生成や補完、デバッグにおいて競合する小型モデルを上回る実力を持っています。さらに、128Kトークンのコンテキストウィンドウを活かせば、プロジェクト全体のコードベースを参照しながら、関連部分を踏まえた提案や修正を提示できます。

また、開発者が求める詳細なコメント付与や関数呼び出しの補助なども得意で、ペアプログラマーのような存在として活用できます。

コストが安いため、大規模開発プロジェクトにおいてもAPI経由で導入しやすく、AIを組み込んだ効率的な開発プロセスを実現できます。初心者にとっては学習支援ツールとして、上級者にとっては効率化の武器として活用できる点が魅力です。

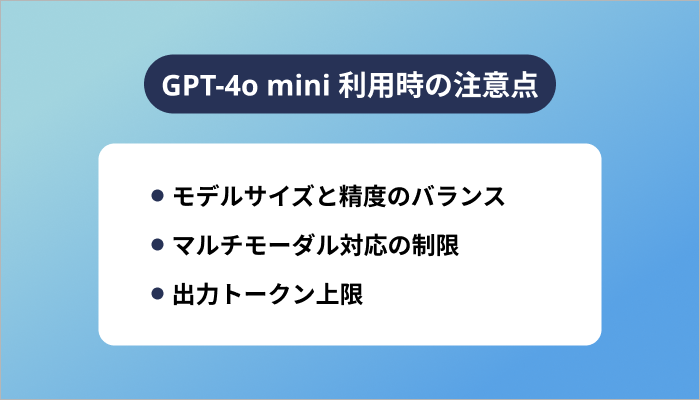

GPT-4o mini 利用時の注意点

GPT-4o mini は、軽量でコスト効率が高いことから幅広いシーンで活用できるモデルですが、利用する際にはいくつか注意すべき点も存在します。

特に「モデルサイズと精度のバランス」「マルチモーダル対応の制限」「出力トークン上限」は、用途によって制約や工夫が必要となる部分です。

これらを理解した上で利用すれば、効率性を損なわずに最大限の価値を引き出すことが可能です。

モデルサイズと精度のバランス

GPT-4o mini は GPT-4o を蒸留し、処理効率と低コストを重視した設計の小型モデルです。

MMLU や HumanEval といったベンチマークで競合の小型モデルを上回る優秀な成績を収めていますが、GPT-4o 本体のような最高水準の精度や多機能性には及びません。特に高度な専門知識を要する研究領域や、複雑で長期的な推論を必要とするタスクでは、やや精度が劣る場面もあります。

そのため、コストと応答速度を重視する場合には最適ですが、正確性を最優先する用途では GPT-4o など上位モデルとの使い分けが求められます。

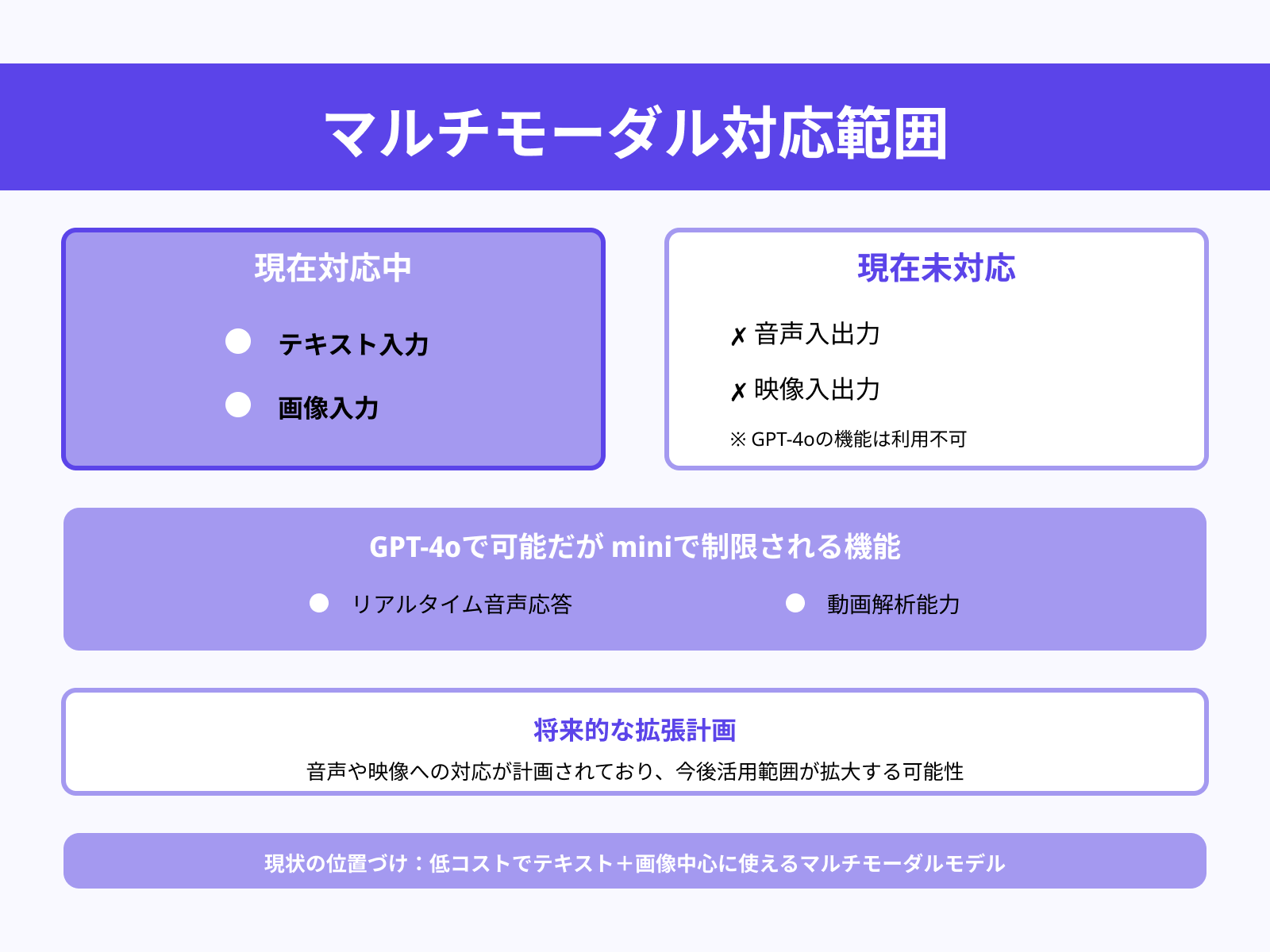

マルチモーダル対応の制限

GPT-4o mini はテキストと画像入力に対応し、文書解析や画像理解といった幅広い用途で活用できます。

しかし、現時点では音声や映像の入出力には対応していません。

GPT-4o が持つリアルタイム音声応答機能や動画解析能力は mini モデルでは利用できないため、これらを必要とするアプリケーションでは制限となります。ただし将来的には、音声や映像への対応も計画されており、今後の拡張によって活用範囲がさらに広がる可能性があります。

現状では「低コストでテキスト+画像中心に使えるマルチモーダルモデル」として認識しておくことが重要です。

出力トークン上限

GPT-4o mini は 1リクエストあたり最大16,384トークンの出力が可能で、従来の小型モデルと比べてもかなり大規模な生成が可能です。

長文記事や詳細なレポートの作成にも十分対応できますが、それ以上の分量が必要な場合は制約となります。例えば論文全体の翻訳や数万語規模のコンテンツ生成には、プロンプトを分割して複数回のリクエストを行う工夫が必要です。

128K のコンテキストウィンドウを活かして大量の入力を処理できる点は強みですが、出力上限がある以上、出力内容を適切に設計・分割する戦略が不可欠となります。

GPT-4o miniの今後に向けた展望

GPT-4o miniは、OpenAI が提供する最新の軽量AIモデルとして、すでに高いコスト効率や高速処理、マルチモーダル対応など多くの利点を兼ね備えています。しかしその進化はまだ始まりにすぎません。

以下では、特に注目すべき3つの展望について詳しく解説します。

さらなるコスト効率の進化

GPT-4o mini は既に非常に安価で提供されていますが、今後はさらにコスト削減が進むと見込まれています。

OpenAI CEOのサム・アルトマン氏は「AI利用コストは毎年およそ10倍のペースで低下している」と発言しており、この流れは次世代モデルにも引き継がれるでしょう。

過去を振り返ると、GPT-3.5 Turbo から GPT-4 Turbo、そして GPT-4o mini に至るまで、トークン単価は大幅に削減されてきました。こうした進化により、従来なら高額な予算が必要だったAI活用も、スタートアップや教育機関、個人開発者でも気軽に導入できるようになります。

将来的には「1ドルで膨大な知識処理が可能」といったレベルに到達する可能性もあり、AIの民主化を大きく前進させるでしょう。

マルチモーダル対応の拡張

現在の GPT-4o mini はテキストと画像入力に対応していますが、今後は音声や動画といったモダリティへの対応が予定されています。

フラッグシップモデルである GPT-4o は既にリアルタイム音声会話や映像処理機能を備えているため、mini にも段階的にその技術が展開されていくことは自然な流れです。

音声が加われば、カスタマーサポートや教育現場での「会話型AIアシスタント」としての利用がさらに広がり、動画対応が実現すれば医療診断支援や製造業の監視システム、映像を使った教育など新たなユースケースが生まれます。

こうした拡張により、GPT-4o mini は「低コストで多機能なマルチモーダルAI」としての地位を確立し、個人から企業まで幅広い層で導入が加速することが期待されます。

安全性と信頼性の強化

AIが社会に浸透するにつれ、安全性と信頼性の確保はますます重要になります。

GPT-4o mini には既に GPT-4o と共通の安全対策が施され、プロンプトインジェクションや誤情報生成を抑制する仕組みが導入されています。

しかし今後はさらに強化され、モデルの透明性や外部評価の仕組みが拡充される見込みです。具体的には「システムカード」や「Preparednessスコアカード」といった安全性評価レポートが公開され、外部専門家のレビューも積極的に取り入れる方針が打ち出されています。

これにより、利用者はモデルのリスクや制約を理解した上で安心して活用できるようになります。

将来的には、医療や公共サービスのように安全基準が厳しい領域でも信頼できるAIとして普及し、社会全体におけるAIの信頼性向上に寄与するでしょう。

まとめ

本記事では、低コストかつ高性能を実現した「GPT-4o mini」について、その概要から特長、料金体系、活用シーン、注意点、そして今後の展望までを解説しました。

従来の大型モデルに比べ、圧倒的なコスト効率と高速性を備えつつ、学術ベンチマークでも高い成果を示している点は大きな魅力です。さらに、カスタマーサポートや教育、コーディング支援といった具体的な活用法に加え、将来的なマルチモーダル対応の拡張や安全性の強化によって、その可能性はますます広がるでしょう。

この記事を参考に、ぜひ自分の目的や環境に合わせてGPT-4o miniを効果的に取り入れ、新たなAI活用の一歩を踏み出してください。