ChatGPTを使ったらバレる?使用が見抜かれる理由と回避策を解説

ChatGPTで書いた文章って本当にバレるの?どれくらいの確率で?

もしバレちゃったらどんな処罰を受けるの?クビになったりする?

バレないようにするコツってあるの?どうやって自然な文章にすればいい?

ChatGPTをはじめとするAI文章生成ツールの普及により、教育現場やビジネスシーンでの活用が急速に広がっています。

一方で、AI検出ツールの導入や人間による目視チェックの精度向上により、AI使用の発覚リスクも年々高まっているのが現状です。レポートや提案書でChatGPTを使った文章がバレてしまい、単位取り消しや契約打ち切りといった深刻な処分を受けるケースが実際に報告されています。

では、どのような場合にAI使用が発覚し、それを避けるためにはどのような対策が有効なのでしょうか。

そこでこの記事では、ChatGPT使用がバレる具体的なパターンから検出ツールの仕組み、発覚時のリスク、そしてバレにくくするための実践的な対策まで、AI文章生成ツールを安全に活用するための重要な情報を包括的に解説します。

- ChatGPT使用の発覚リスクと検出される具体的なパターンがわかる

- 教育現場やビジネスでバレた場合の深刻なペナルティの実態がわかる

- AI使用を隠すテクニックと透明性を保った活用方法がわかる

ChatGPTの特徴を詳しく知りたい人は、次の記事を参考にしてください。

なお、生成AIを学び副業や業務効率化を実現したい人は「侍エンジニア」をお試しください。

侍エンジニアでは現役エンジニアと学習コーチが学習をサポート。AIプログラミングやPython・VBAの習得を通じて、手間のかかる作業を効率化する方法を学べます。

受講料が最大80%OFFになる「給付金コース」も提供中。未経験から挫折なくAIスキルを習得したい人は、ぜひ一度お試しください。

ChatGPTを使った文章はバレるのか?

ChatGPTなどのAIツールで生成した文章が第三者に発覚するかどうかは、現在多くの人が抱える重要な関心事です。結論から言えば、完全にバレないとは言い切れませんが、使用方法次第でリスクを大幅に軽減できるでしょう。

ここからは、AI文章の検出可能性について以下の観点から詳しく解説していきます。

それぞれ詳しく解説していきます。

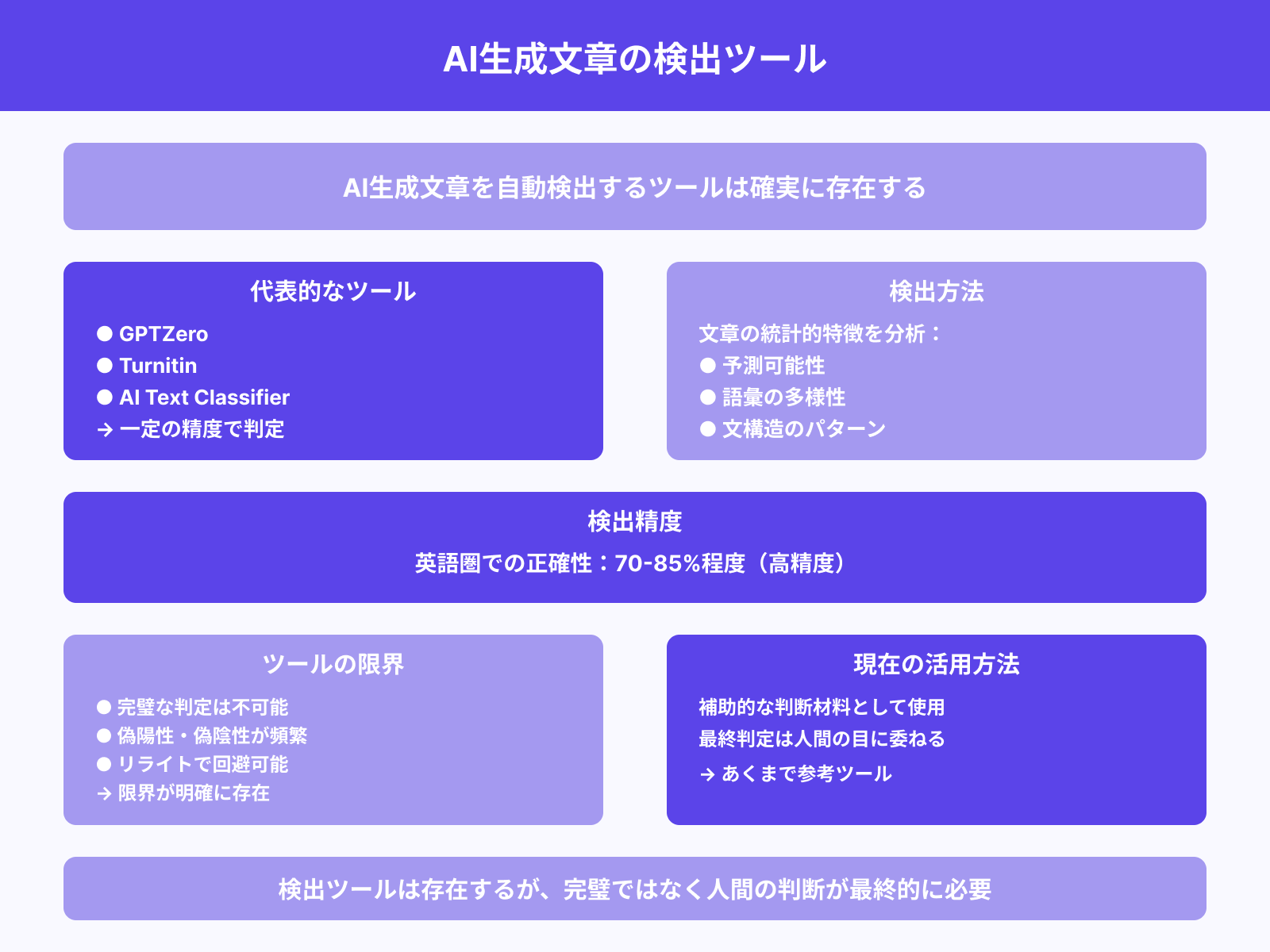

検出ツールによる判定は可能?

AI生成文章を自動で検出するツールは確実に存在し、一定の精度で判定を行っています。代表的なツールには「GPTZero」「Turnitin」「AI Text Classifier」などがあり、文章の統計的特徴を分析してAI生成かどうかを推測するのです。

これらのツールは、文章の予測可能性や語彙の多様性、文構造のパターンなどを総合的に評価しています。特に英語圏では検出精度が高く、70-85%程度の正確性を持つとされているでしょう。

ただし、完璧な判定は不可能であり、偽陽性(人間の文章をAIと誤判定)や偽陰性(AI文章を人間と誤判定)も頻繁に発生します。また、リライトや編集を加えることで検出を回避できるケースも多く、ツールの限界も明確に存在するのです。

現時点では補助的な判断材料として活用されることが多く、最終的な判定は人間の目に委ねられることがほとんどでしょう。

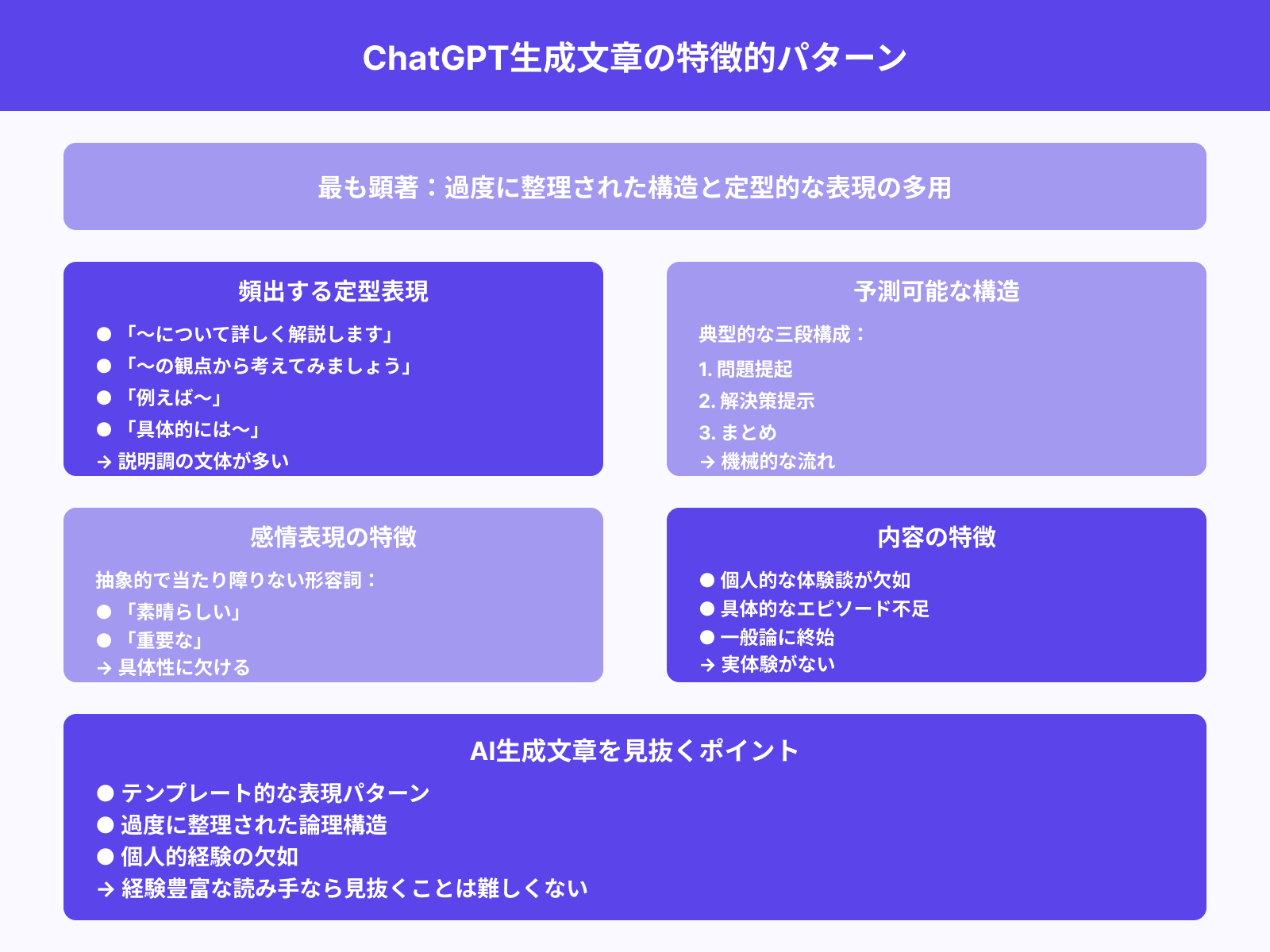

AI文章の特徴(不自然さ・テンプレ化)

ChatGPTで生成された文章には、経験豊富な読み手なら気づく特徴的なパターンが存在します。

最も顕著なのは、過度に整理された構造と定型的な表現の多用です。

典型的な例として、「〜について詳しく解説します」「〜の観点から考えてみましょう」といった説明調の文体が頻出する傾向があります。また、具体例を挙げる際も「例えば〜」「具体的には〜」といった接続表現が機械的に使われがちです。

文章の流れも予測可能で、問題提起→解決策提示→まとめという三段構成を取ることが多いでしょう。

感情表現においても、「素晴らしい」「重要な」といった抽象的で当たり障りのない形容詞が選ばれる傾向があります。さらに、個人的な体験談や具体的なエピソードが欠如しており、一般論に終始することが多いのも特徴の一つです。

こうしたテンプレート的な表現パターンに慣れた人であれば、AI生成文章を見抜くことは決して難しくありません。

人間とAIの文体の違いとは?

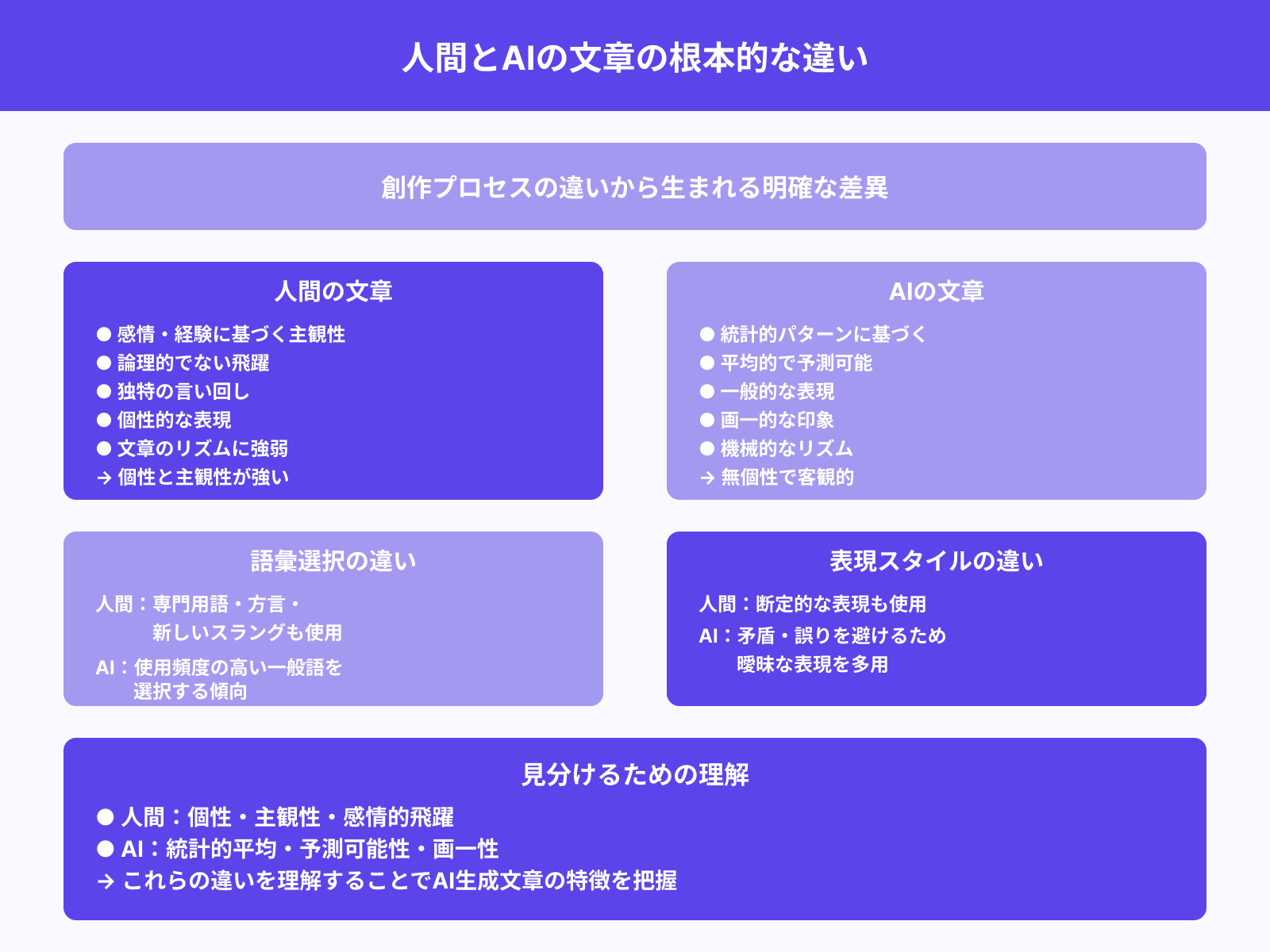

人間とAIの文章には、根本的な創作プロセスの違いから生まれる明確な差異があります。

人間の文章は感情や経験に基づく主観性が強く、時として論理的でない飛躍や独特の言い回しが含まれるものです。一方、AIは大量のテキストデータから学習した統計的パターンに基づいて文章を生成するため、平均的で予測可能な表現になりがちでしょう。

人間特有の癖や個性的な表現がAI文章には現れにくく、画一的な印象を与えることが多いのです。語彙選択においても、AIは使用頻度の高い一般的な単語を選ぶ傾向があり、専門用語や方言、新しいスラングなどの使用は控えめになります。

文章のリズムや間の取り方も機械的で、人間が自然に行う強弱の付け方や読み手への配慮が不足することがあるでしょう。また、矛盾や誤りを避けようとするあまり、断定的な表現を避けて曖昧な表現を多用する傾向も見られます。

こうした違いを理解することで、AI生成文章の特徴をより深く把握できるはずです。

教育現場でChatGPT使用がバレるケース

教育機関におけるChatGPT使用の発覚は、学生にとって深刻な問題となる可能性があります。特に近年は多くの大学や高校でAI検出ツールの導入が進んでおり、従来よりも発覚リスクが高まっているのが現状です。

ここからは、教育現場でのAI使用発覚について以下の側面から詳しく見ていきます。

それぞれ詳しく解説していきます。

レポート・論文のAI検出ツール導入例

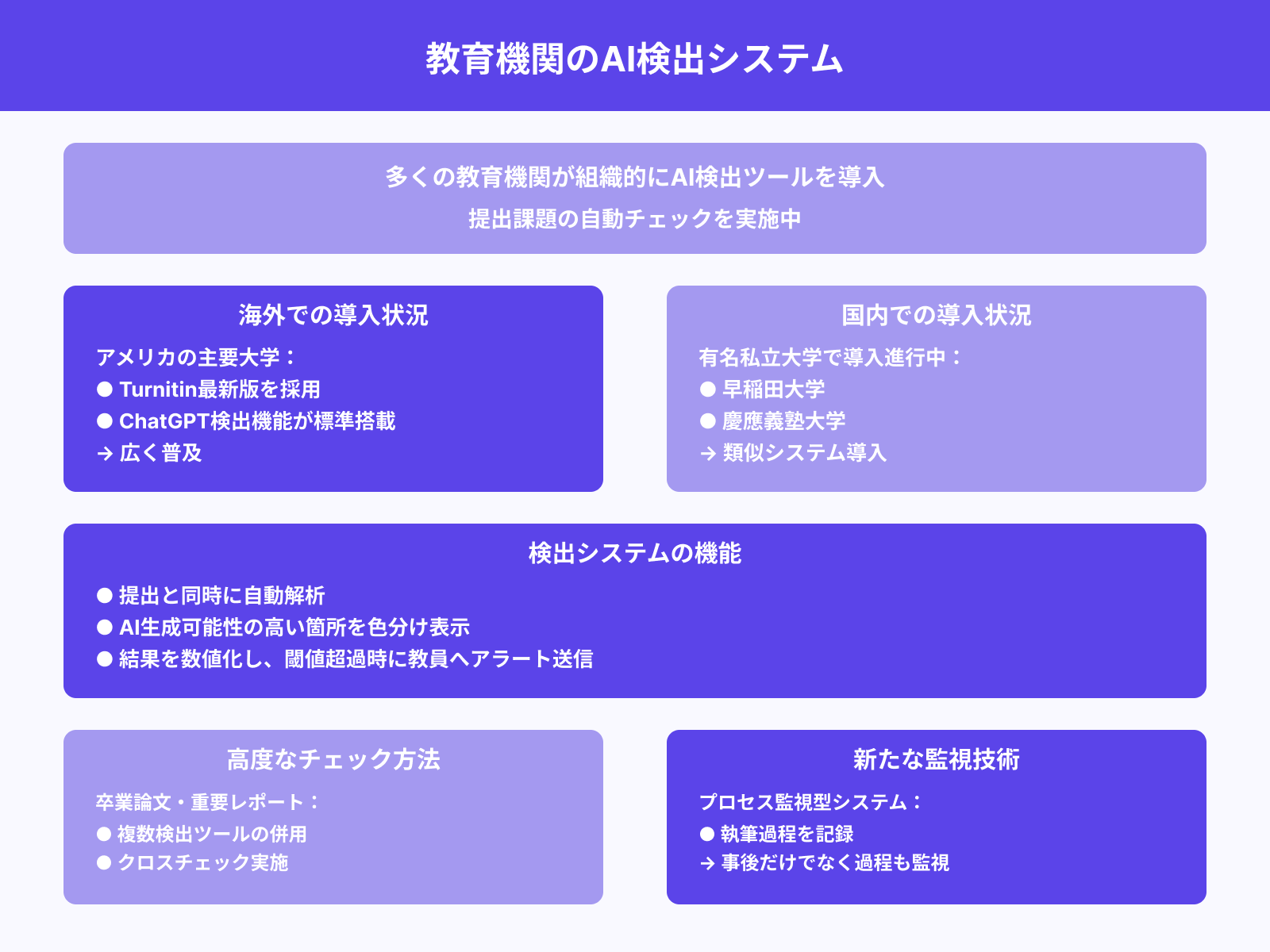

多くの教育機関が組織的にAI検出ツールを導入し、提出される課題の自動チェックを実施しています。

アメリカの主要大学では「Turnitin」の最新版が広く採用されており、ChatGPT検出機能が標準搭載されているのです。日本国内でも、早稲田大学や慶應義塾大学をはじめとする有名私立大学で類似のシステム導入が進んでいます。

これらのツールは提出と同時に自動的に文章を解析し、AI生成の可能性が高い箇所を色分けして表示する機能を持っているでしょう。検出結果は数値化され、一定の閾値を超えた場合は自動的に教員にアラートが送信される仕組みになっています。

特に卒業論文や重要なレポートでは、複数の検出ツールを併用してクロスチェックを行う大学も増加中です。また、提出後の事後チェックだけでなく、執筆過程を記録する「プロセス監視型」のシステムも登場しています。

こうした技術的な監視体制の強化により、AI使用の隠蔽は以前よりも困難になっているのが実情でしょう。

教員が気づくパターンとは?

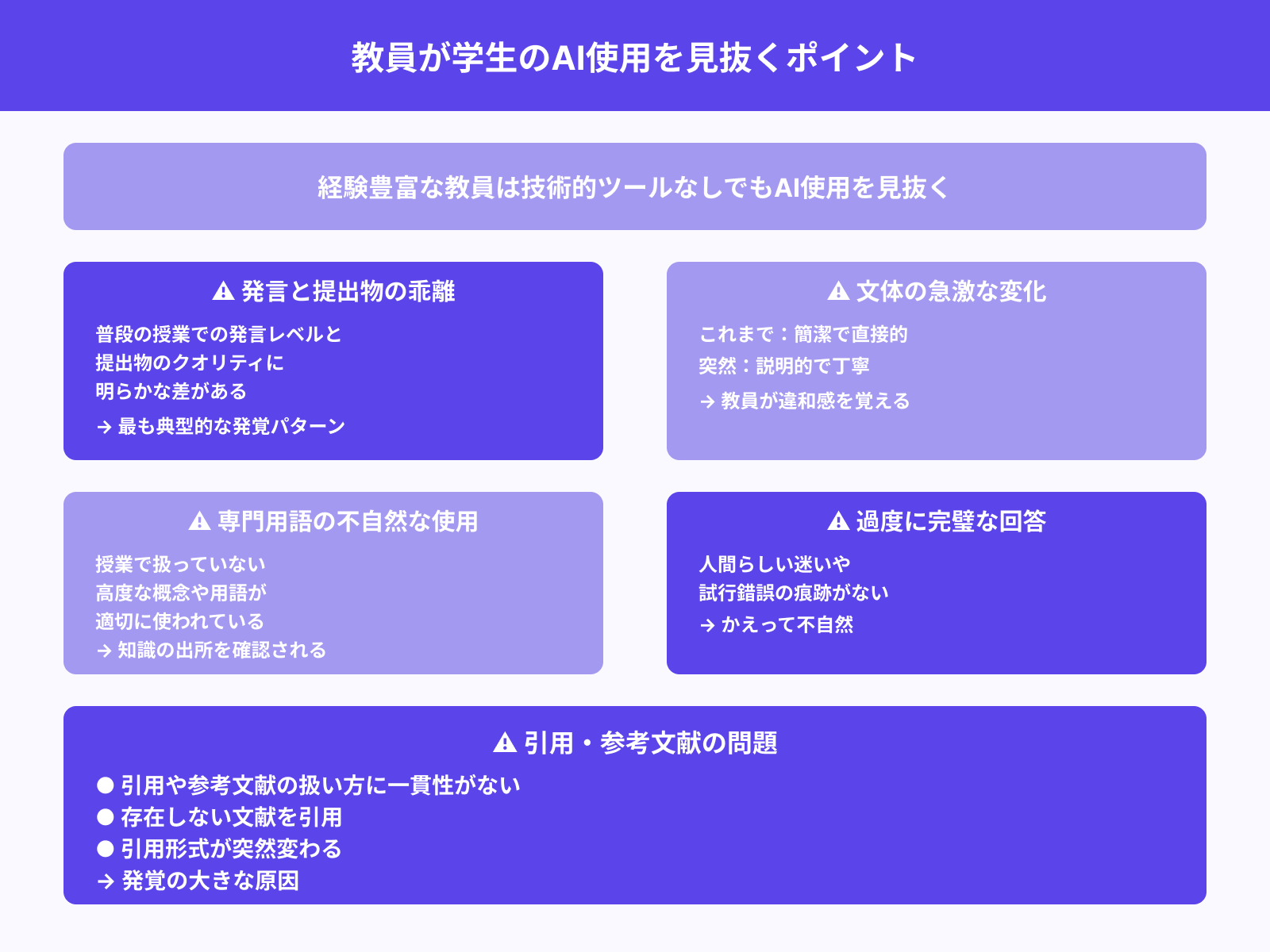

経験豊富な教員は、技術的なツールに頼らずとも学生のAI使用を見抜くことが多いものです。

最も典型的なのは、普段の授業での発言レベルと提出物のクオリティに明らかな乖離がある場合でしょう。文体の急激な変化も発覚の大きな要因となります。

これまでの課題では簡潔で直接的な表現を使っていた学生が、突然説明的で丁寧な文章を書くようになれば、教員は違和感を覚えるはずです。

専門用語の使い方も重要な判断材料になっています。授業で扱っていない高度な概念や用語が適切に使われている場合、その知識をどこで得たのかを確認される可能性が高いでしょう。

また、課題の要求事項に対して過度に完璧な回答をする学生も注意が必要です。人間らしい迷いや試行錯誤の痕跡がない文章は、かえって不自然さを演出してしまうことがあります。

さらに、引用や参考文献の扱い方に一貫性がない場合や、存在しない文献を引用している場合なども発覚の原因となるでしょう。

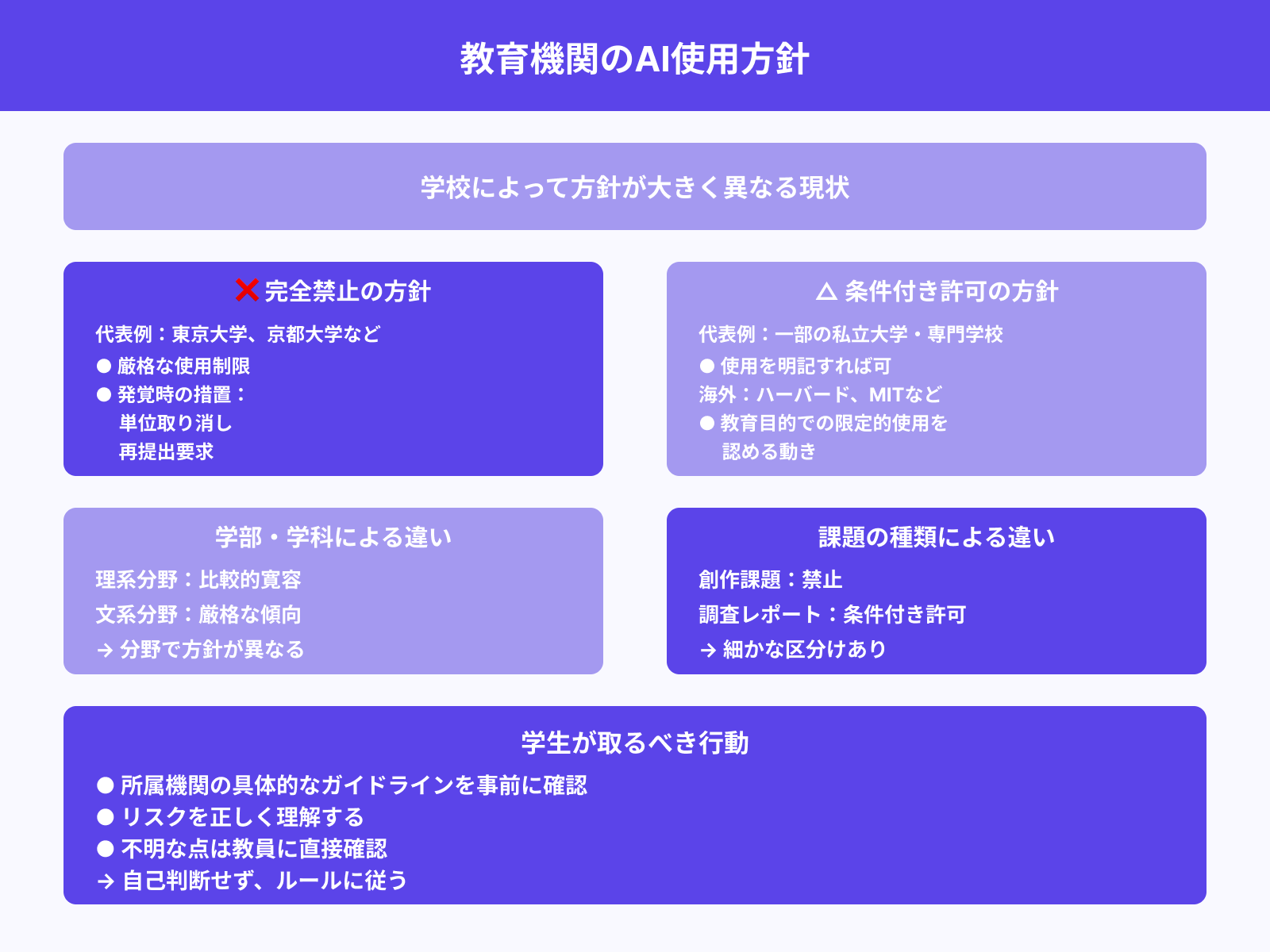

学校によっては禁止・許可に差がある

ChatGPTをはじめとするAIツールに対する教育機関の方針は、学校によって大きく異なっているのが現状です。完全禁止を打ち出している大学がある一方で、適切な使用であれば認める方針の学校も存在します。

禁止派の代表例として、東京大学や京都大学などの国立大学では厳格な使用制限を設けています。これらの大学では、AI使用の発覚即座に単位取り消しや再提出といった厳しい措置が取られることがあるでしょう。

対照的に、一部の私立大学や専門学校では「使用を明記すれば可」という条件付き許可制を採用しています。海外では、ハーバード大学やMITなどの名門校でも、教育目的での限定的なAI使用を認める動きが見られるのです。

また、学部や学科によっても方針が異なることが多く、理系分野では比較的寛容な一方、文系分野では厳格な傾向があります。さらに課題の種類によっても扱いが変わり、創作課題では禁止、調査レポートでは条件付き許可といった細かな区分けを設けている学校もあるでしょう。

学生は所属する機関の具体的なガイドラインを事前に確認し、リスクを正しく理解した上で行動することが重要です。

ビジネス・就職活動でChatGPTの使用がバレるリスク

ビジネスシーンや就職活動におけるChatGPT使用の発覚は、キャリアに深刻な影響を与える可能性があります。企業側もAI使用に対する警戒を強めており、従来以上に慎重な対応が求められる状況です。

ここからは、職業的な場面でのAI使用リスクについて以下の観点から解説します。

それぞれ詳しく解説していきます。

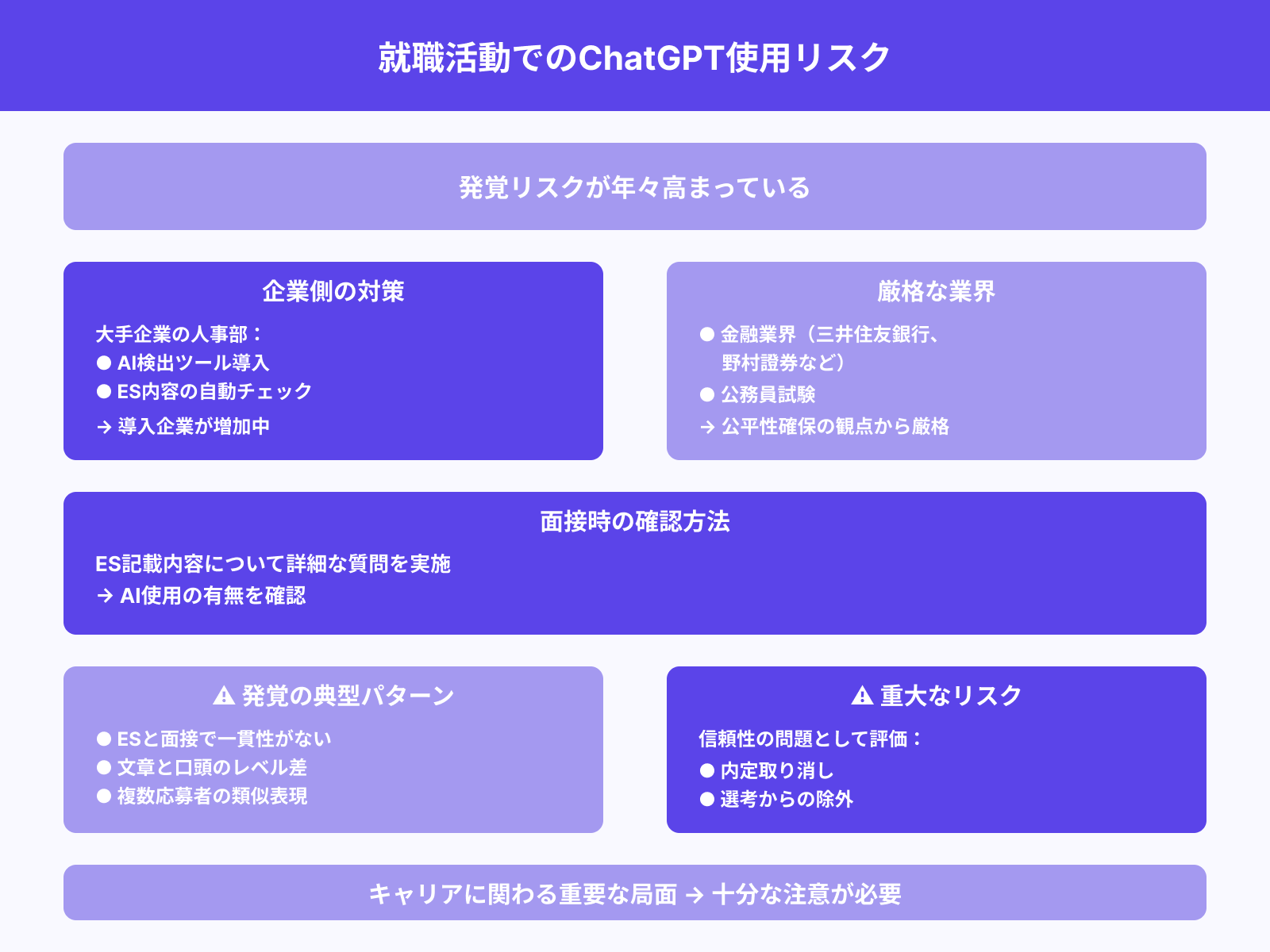

エントリーシートにおける検出の可能性

就職活動におけるエントリーシート(ES)でのChatGPT使用は、採用担当者に発覚するリスクが年々高まっています。

大手企業の人事部では、AI検出ツールを導入してES内容の自動チェックを実施するケースが増加中です。特に金融業界や公務員試験では、公平性確保の観点からAI使用を厳格に取り締まる傾向があります。

三井住友銀行や野村證券などの大手金融機関では、面接時にES記載内容について詳細な質問を行い、AI使用の有無を確認することがあるでしょう。採用担当者が違和感を覚える典型例として、ES内容と面接での発言内容に一貫性がない場合が挙げられます。

文章では高度な語彙や論理構成を示していたにも関わらず、口頭では同レベルの表現ができない学生は要注意です。また、複数の応募者が類似した表現や構成を使用している場合、組織的なAI使用を疑われる可能性があります。

ES添削サービスでChatGPTを使用している場合、同じプロンプトで生成された類似文章が複数提出されることで発覚するケースも報告されているでしょう。

最終的には信頼性の問題として評価され、内定取り消しや選考からの除外につながる可能性もあるため、十分な注意が必要です。

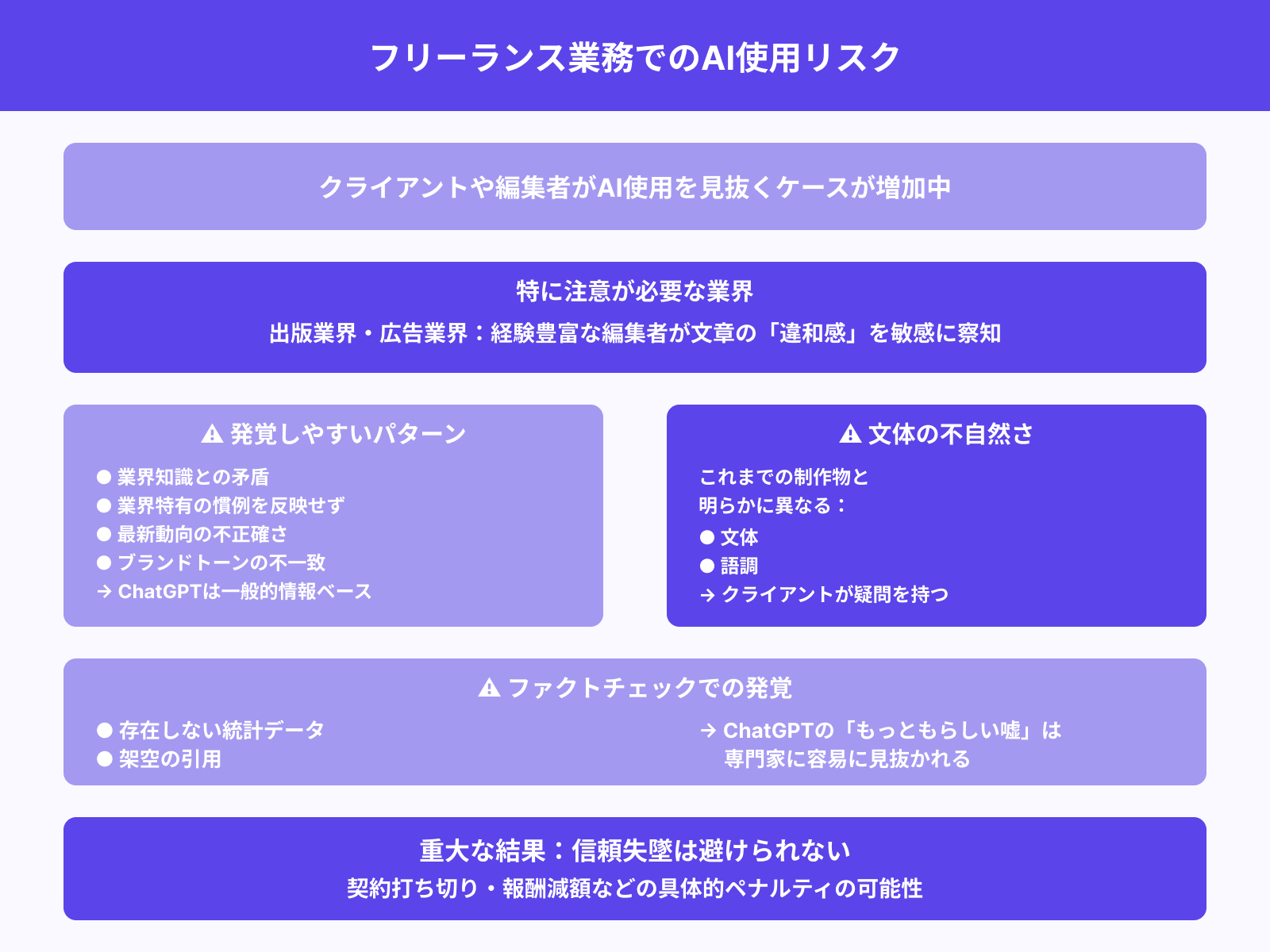

クライアントチェックや編集者の違和感

フリーランスや業務委託でコンテンツ制作を行う際、クライアントや編集者がAI使用を見抜くケースが増えています。特に出版業界や広告業界では、経験豊富な編集者が文章の「違和感」を敏感に察知することが多いものです。

最も発覚しやすいのは、クライアントの業界知識や専門性と矛盾する内容を含んだ場合でしょう。

ChatGPTは一般的な情報に基づいて回答するため、業界特有の慣例や最新動向を正確に反映できないことがあります。また、ブランドトーンやターゲット読者に合わない表現が含まれている場合も問題となります。

これまでの制作物と明らかに異なる文体や語調で納品すれば、クライアントは制作プロセスに疑問を持つはずです。編集者によるファクトチェックの過程で、存在しない統計データや引用が発見されることもあります。

ChatGPTが生成する「もっともらしい嘘」は、専門家の目には容易に見抜かれてしまうでしょう。長期的な取引関係においては、一度でもAI使用が発覚すれば信頼失墜は避けられません。

契約打ち切りや報酬減額といった具体的なペナルティを受ける可能性も十分にあるのです。

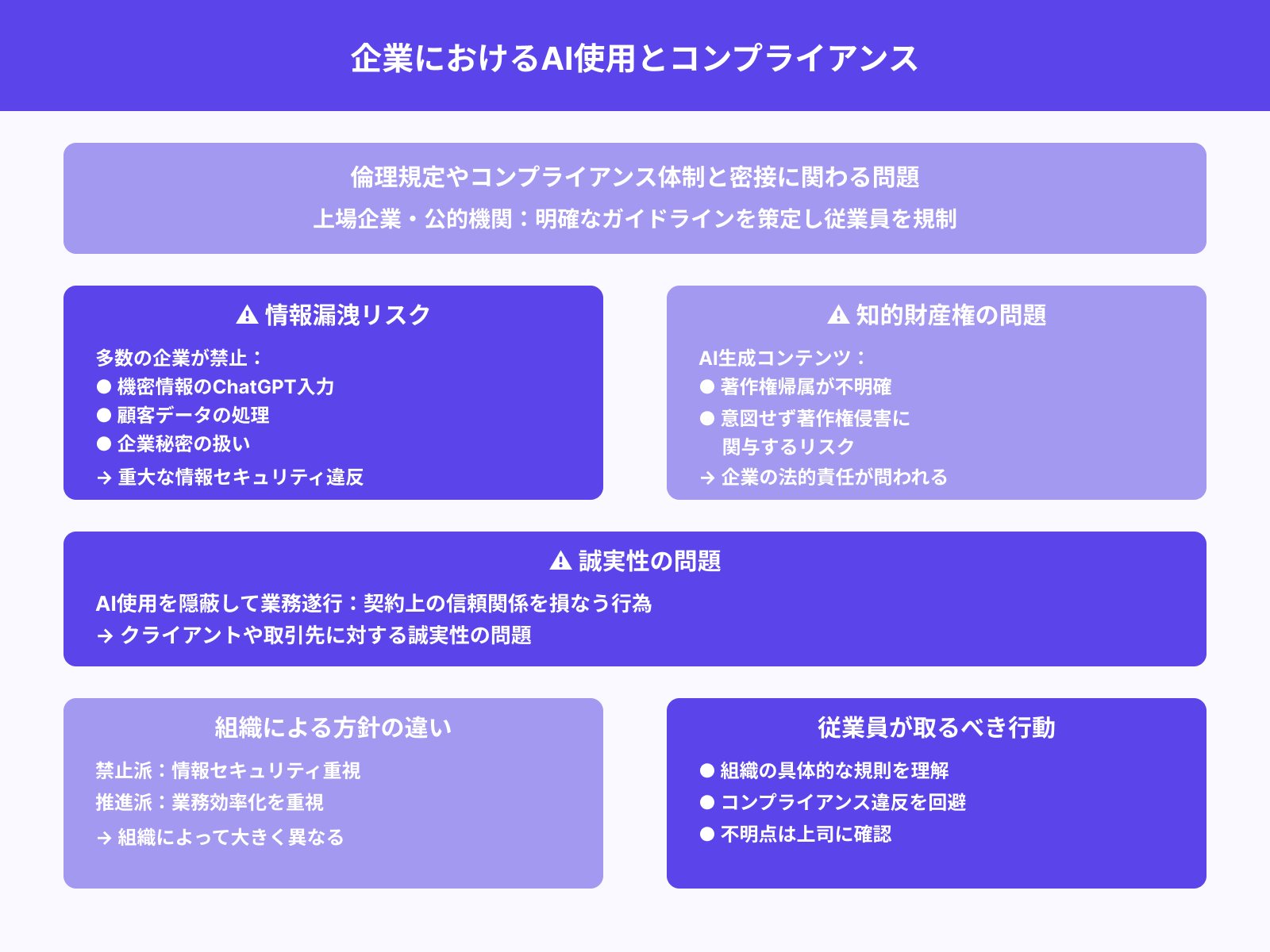

企業の倫理・コンプライアンスとの関係

企業におけるAI使用は、組織の倫理規定やコンプライアンス体制と密接に関わる問題となっています。特に上場企業や公的機関では、AI使用に関する明確なガイドラインを策定し、従業員の行動を規制するケースが増加中です。

情報漏洩リスクの観点から、機密情報をChatGPTに入力することを禁止している企業が多数存在します。顧客データや企業秘密を含む文書をAIツールで処理した場合、重大な情報セキュリティ違反として懲戒処分の対象となる可能性があるでしょう。

知的財産権の問題も深刻です。

AI生成コンテンツの著作権帰属が不明確な現状では、企業が意図せず著作権侵害に関与するリスクがあります。また、クライアントや取引先に対する誠実性の問題として捉える企業も少なくありません。

AI使用を隠蔽して業務を遂行することは、契約上の信頼関係を損なう行為と見なされることがあるのです。一方で、業務効率化の観点からAI活用を推進する企業も存在し、組織によって方針が大きく異なっています。

従業員は所属する組織の具体的な規則を理解し、コンプライアンス違反を避けるための適切な行動を取ることが不可欠でしょう。

ChatGPTの使用を検出するツールとは?

AI生成文章を見抜くための検出ツールは急速に進化しており、その仕組みや精度について正しく理解することが重要です。ただし、これらのツールには明確な限界も存在し、過信は禁物と言えるでしょう。

ここからは、AI検出ツールについて以下の側面から詳しく解説します。

それぞれ詳しく解説していきます。

GPTZero・Turnitinなどの仕組み

代表的なAI検出ツールである「GPTZero」と「Turnitin」は、異なるアプローチでAI生成文章を判定しています。

GPTZeroは「perplexity(困惑度)」と「burstiness(突発性)」という2つの指標を用いて、文章の予測可能性を測定するのです。perplexityは文章の予測しやすさを表し、AIが生成しやすい文章ほど数値が低くなります。

一方、bustinessは文章の変動性を示し、人間の文章に見られる不規則なリズムを検出する指標として機能するでしょう。

Turnitinはより包括的なアプローチを採用し、文章の統計的特徴、語彙の多様性、構文パターンなどを総合的に分析します。また、既知のAI生成文章データベースとの照合も行い、類似パターンの検出を試みているのです。

これらのツールは機械学習アルゴリズムを基盤としており、大量の人間・AI文章ペアで訓練されています。

ただし、AIモデルの進化に伴って検出精度は変動し、新しいAIツールに対しては対応が遅れる傾向があるでしょう。検出結果は確率として表示され、100%の確実性を保証するものではありません。

あくまで補助的な判断材料として活用されることが前提となっています。

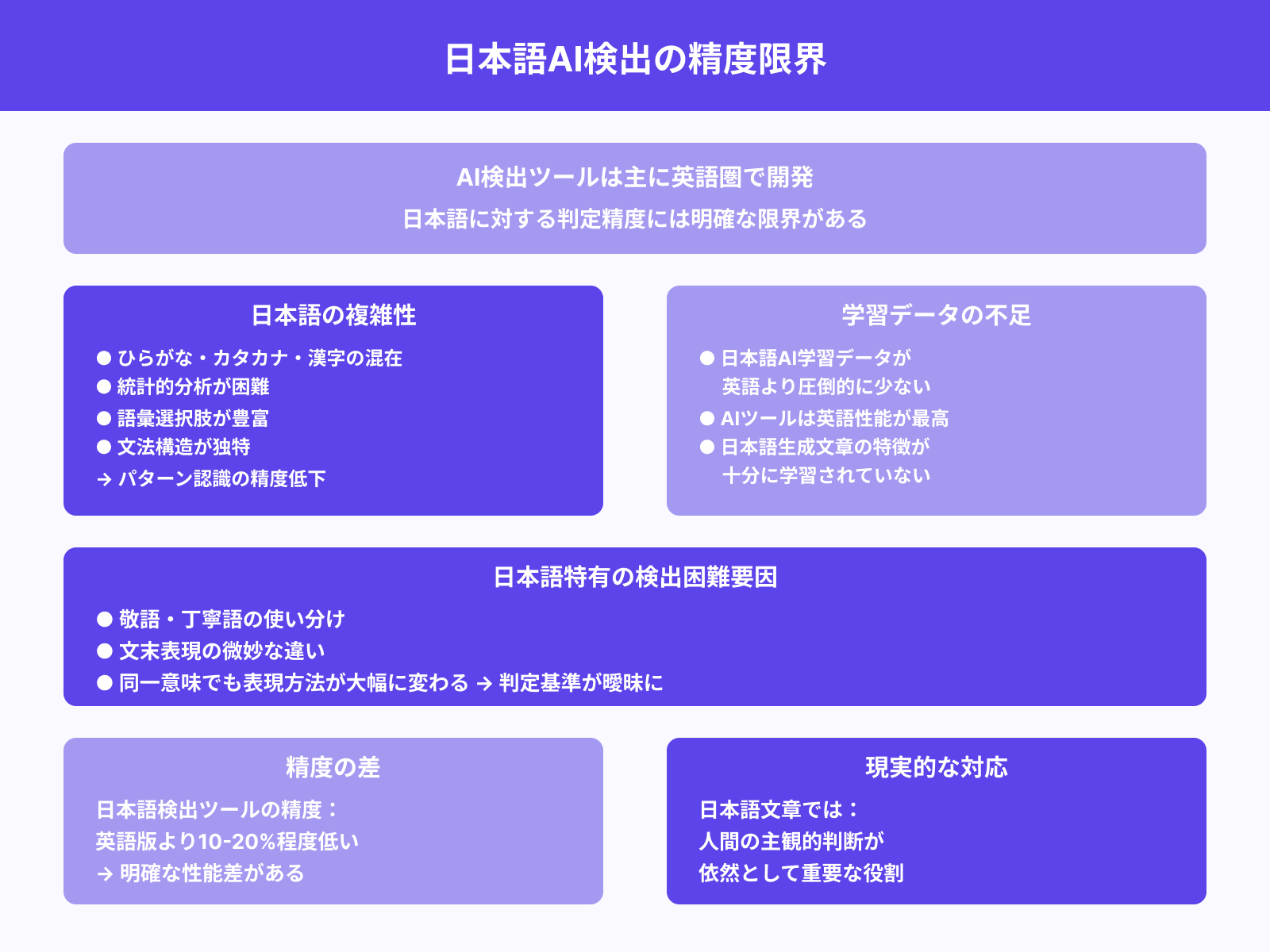

日本語での判定精度の限界

AI検出ツールの多くは英語圏で開発されており、日本語に対する判定精度には明確な限界があります。

日本語特有の文法構造や表現方法が、検出アルゴリズムの予測を困難にしているのが現状です。ひらがな、カタカナ、漢字が混在する日本語の複雑性は、統計的分析を難しくしています。

同じ意味を表現する際の語彙選択肢が英語よりも豊富で、パターン認識の精度低下を招いているでしょう。また、日本語のAI学習データが英語と比較して圧倒的に少ないことも精度に影響しています。

ChatGPTやClaude等の主要AIツールは英語での性能が最も高く、日本語生成文章の特徴が十分に学習されていない可能性があるのです。敬語や丁寧語の使い分け、文末表現の微妙な違いなども検出を困難にする要因となります。

日本語の文章では、同一の意味内容でも表現方法が大幅に変わることが多く、AI検出ツールの判定基準が曖昧になりがちでしょう。

現在の日本語対応検出ツールの精度は、英語版と比較して10-20%程度低いとされています。そのため、日本語文章においては人間の主観的判断が依然として重要な役割を果たしているのです。

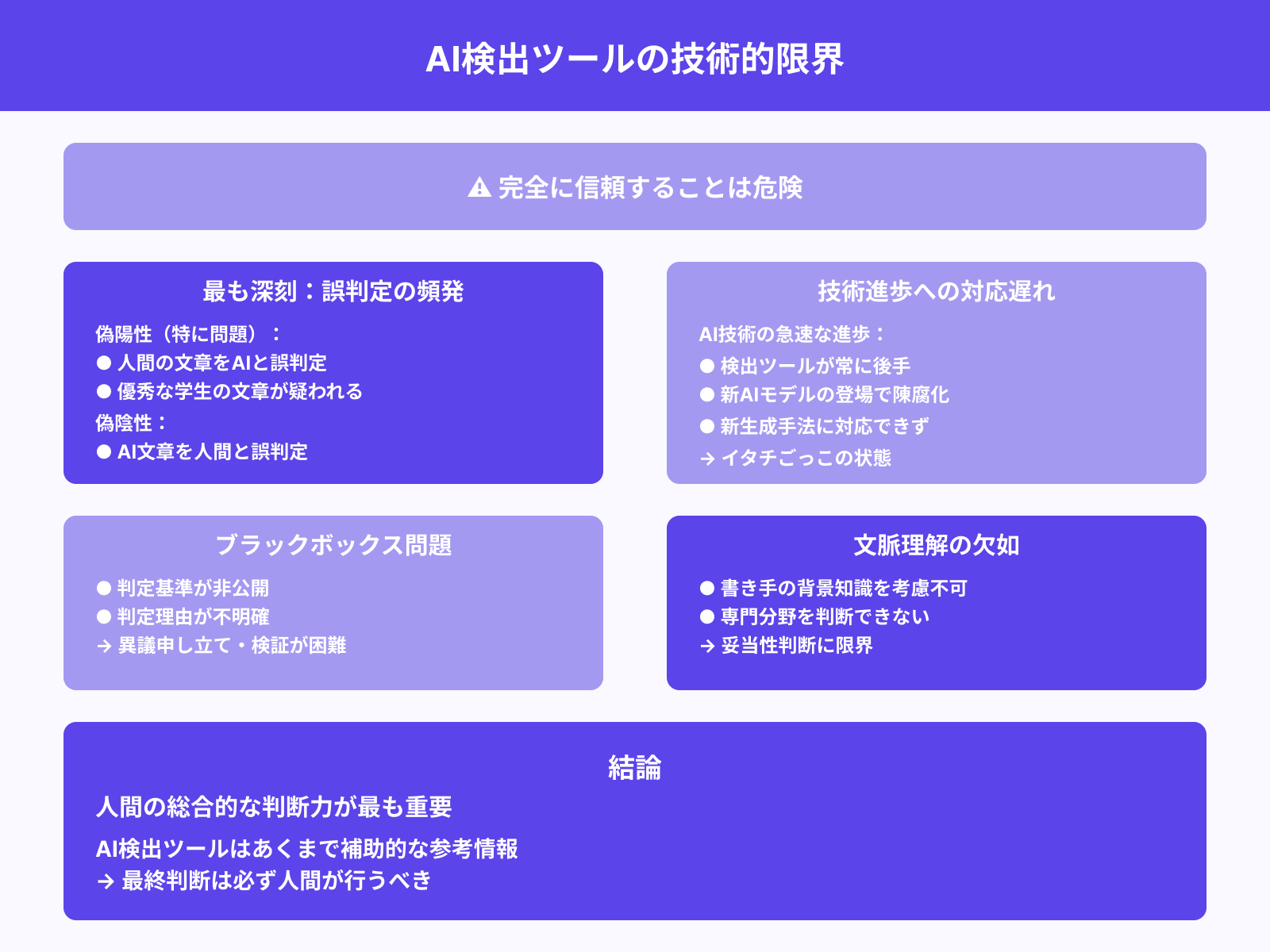

ツールを過信すべきでない理由

AI検出ツールには技術的な限界があり、完全に信頼することは危険です。

最も深刻な問題は、偽陽性(人間の文章をAIと誤判定)と偽陰性(AI文章を人間と誤判定)の両方が頻繁に発生することでしょう。偽陽性は特に問題で、優秀な学生や熟練したライターの文章が「AI生成」と判定されるケースが相次いでいます。

論理的で整理された文章ほどAIらしいと判定される傾向があり、質の高い人間の文章が不当に疑われるリスクがあるのです。また、AI技術の急速な進歩により、検出ツールの対応が常に後手に回っています。

新しいAIモデルや生成手法が登場する度に、既存の検出システムは陳腐化してしまうでしょう。さらに、検出ツールの判定基準は公開されておらず、ブラックボックス化している問題もあります。

なぜその判定になったのかが不明確で、異議申し立てや検証が困難な状況です。文脈や専門性を考慮できない点も大きな制約となっています。同じ文章でも、書き手の背景知識や専門分野によって妥当性は変わるはずですが、ツールはそうした要素を判断できません。

最終的には、人間の総合的な判断力がAI検出において最も重要な要素であり続けるでしょう。

ChatGPTの使用がバレにくくなる工夫と方法

ChatGPTを使用しつつも発覚リスクを最小限に抑えるためには、適切な後処理と編集技術が不可欠です。単純にAI出力をそのまま使用するのではなく、人間らしさを加える工夫が重要になります。

ここからは、AI使用の痕跡を薄める具体的な手法について以下の観点から解説します。

それぞれ詳しく解説していきます。

生成文のリライトと自然な文体調整

ChatGPTが生成した文章をそのまま使用せず、徹底的なリライトを行うことが発覚回避の基本です。

最初に取り組むべきは、AI特有の定型的な表現パターンの除去でしょう。

「〜について解説します」「〜の観点から考えてみましょう」といった説明調の文章は、より自然な表現に置き換える必要があります。「〜がポイントだ」「〜に注目したい」など、断定的で個人的な語調に変更することで人間らしさが増すのです。

文章の長さにも変化を付けることが重要になります。AIは均等な長さの文を生成しがちですが、人間の文章には自然な長短のリズムがあるものです。

語彙選択においても、より具体的で感情的な表現を積極的に取り入れましょう。「重要な」を「決定的な」に、「多くの」を「かなりの数の」に変更するなど、ニュアンスの豊かな語彙を使用することで個性が生まれます。

また、口語的な表現や方言、世代特有のスラングを適度に混ぜることも効果的です。ただし、不自然に感じられない程度に留めることが大切でしょう。

最終的には、自分が普段使う文体に近づけることで、一貫性のある自然な文章に仕上げられます。

出力後の構成変更や情報加筆の重要性

AI生成文章の構成をそのまま使用することは、検出リスクを高める大きな要因となります。ChatGPTは予測可能なパターンで文章を構成するため、構造レベルでの大幅な変更が不可欠です。

最も効果的なのは、段落の順序を入れ替えることでしょう。結論を冒頭に持ってきたり、具体例を先に示してから理論を説明するなど、論理展開を再構築することで独自性が生まれます。

また、AI出力には含まれていない情報を積極的に加筆することも重要です。最新のデータや事例、個人的な見解や体験談を追加することで、文章の価値と独自性を高められるでしょう。

引用や参考文献についても、AI生成のものをそのまま使用するのは危険です。実在する信頼できる情報源を自分で調査し、適切に引用することで学術的な信頼性を確保できます。

小見出しや章立ても独自のものに変更しましょう。

AIが提案する見出しは一般的すぎることが多く、より具体的で魅力的なタイトルに変更することで読み手の関心を引くことが可能です。さらに、図表やグラフなどの視覚的要素を追加することで、文章全体の構成をより豊かにできるでしょう。

自分の言葉と混ぜて再編集するテクニック

AI生成文章と自分の文章を効果的に融合させることで、検出を困難にしつつオリジナリティを確保できます。重要なのは、完全にAI依存にならず、自分の思考と表現を積極的に組み込むことです。

まず、AI出力を参考程度に留め、自分なりの解釈や意見を必ず加えましょう。たとえAIが提示した情報が正確でも、それに対する個人的な見解や疑問を付け加えることで独自性が生まれます。

具体的な体験談やエピソードの挿入も非常に効果的です。

AIには個人的な経験を語れないため、実体験に基づく記述は人間らしさの証明となるでしょう。文章の冒頭と結論部分は特に重要で、これらは完全に自分の言葉で書くことをお勧めします。

導入部分で読み手の関心を引く個人的なエピソードを語り、結論部分で自分なりの提言や感想を述べることで、文章全体に一貫した個性が生まれるのです。

専門用語の使い方にも注意を払いましょう。自分の知識レベルに合った表現を使用し、不自然に高度すぎる概念は避けることが大切です。

最終的には、声に出して読み返してみることで自然さを確認できます。自分が普段話すような調子で書けているかどうかが、人間らしい文章かどうかの重要な判断基準となるでしょう。

ChatGPTの使用がバレたときのリスク・ペナルティ

ChatGPT使用が発覚した場合のペナルティは、状況や所属組織によって大きく異なります。軽微な注意で済む場合もあれば、深刻な処分を受ける可能性もあるため、事前にリスクを把握しておくことが重要です。

ここからは、AI使用発覚時の具体的なリスクについて以下の分野別に解説します。

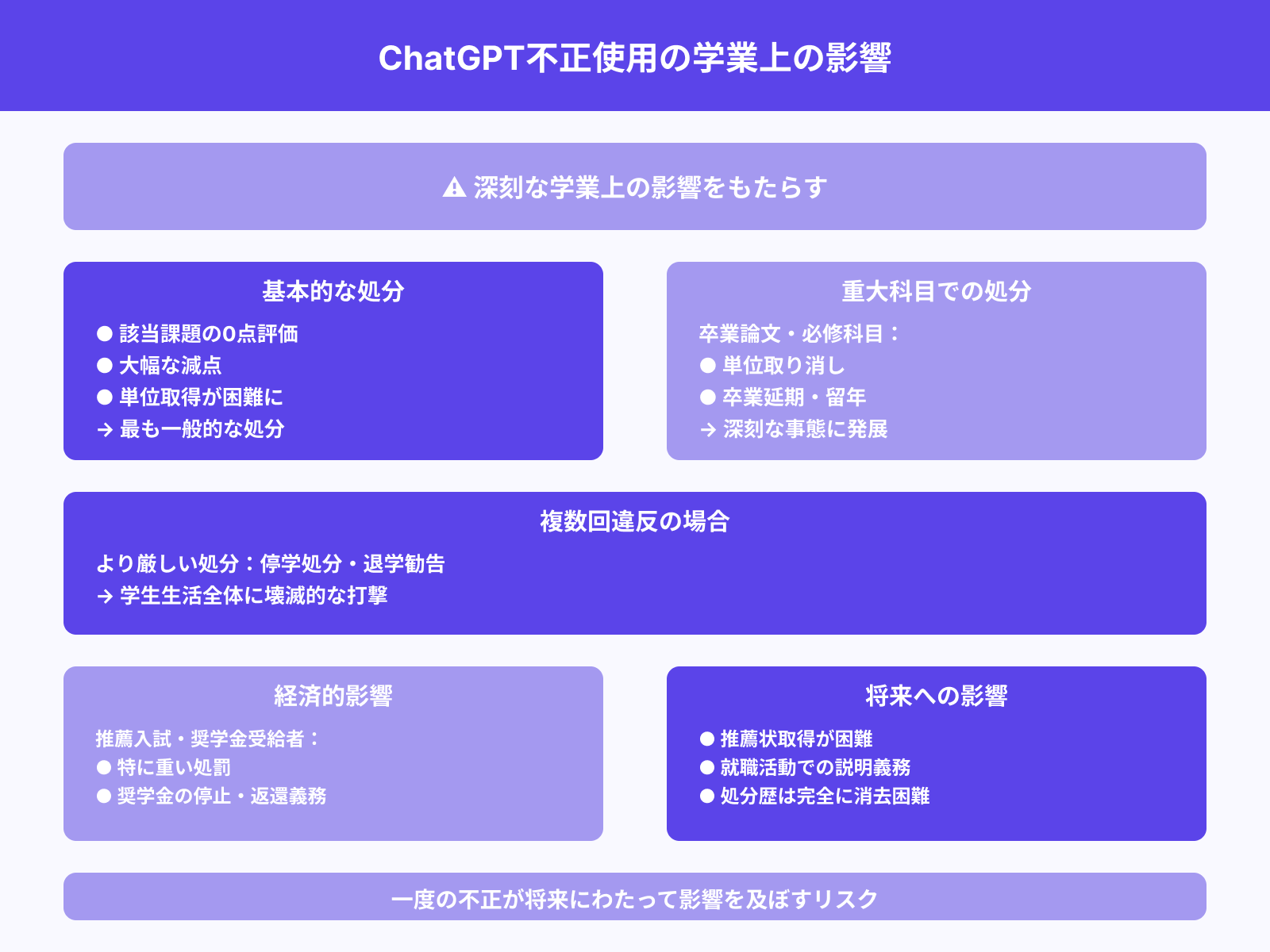

教育現場:単位取り消しや減点の可能性

大学や高校でのChatGPT使用発覚は、学生にとって深刻な学業上の影響をもたらします。最も一般的な処分は該当課題の0点評価や大幅な減点であり、これにより単位取得が困難になるケースが多いでしょう。

重要科目でのAI使用が発覚した場合、単位そのものが取り消される可能性があります。特に卒業論文や必修科目での不正が判明すれば、卒業時期の延期や留年といった深刻な事態に発展することもあるのです。

複数回の違反が確認された場合、より厳しい処分が科される傾向があります。

停学処分や退学勧告といった極端なケースも報告されており、学生生活全体に壊滅的な打撃を与える可能性があるでしょう。また、推薦入試や奨学金受給者の場合、AI使用による不正は特に重く処罰されることがあります。

奨学金の停止や返還義務が生じる場合もあり、経済的な負担も無視できません。就職活動への影響も深刻で、大学からの推薦状取得が困難になったり、面接で説明を求められたりする可能性があります。

一度記録に残った処分歴は完全に消去することが難しく、将来にわたって影響を及ぼすリスクがあるのです。

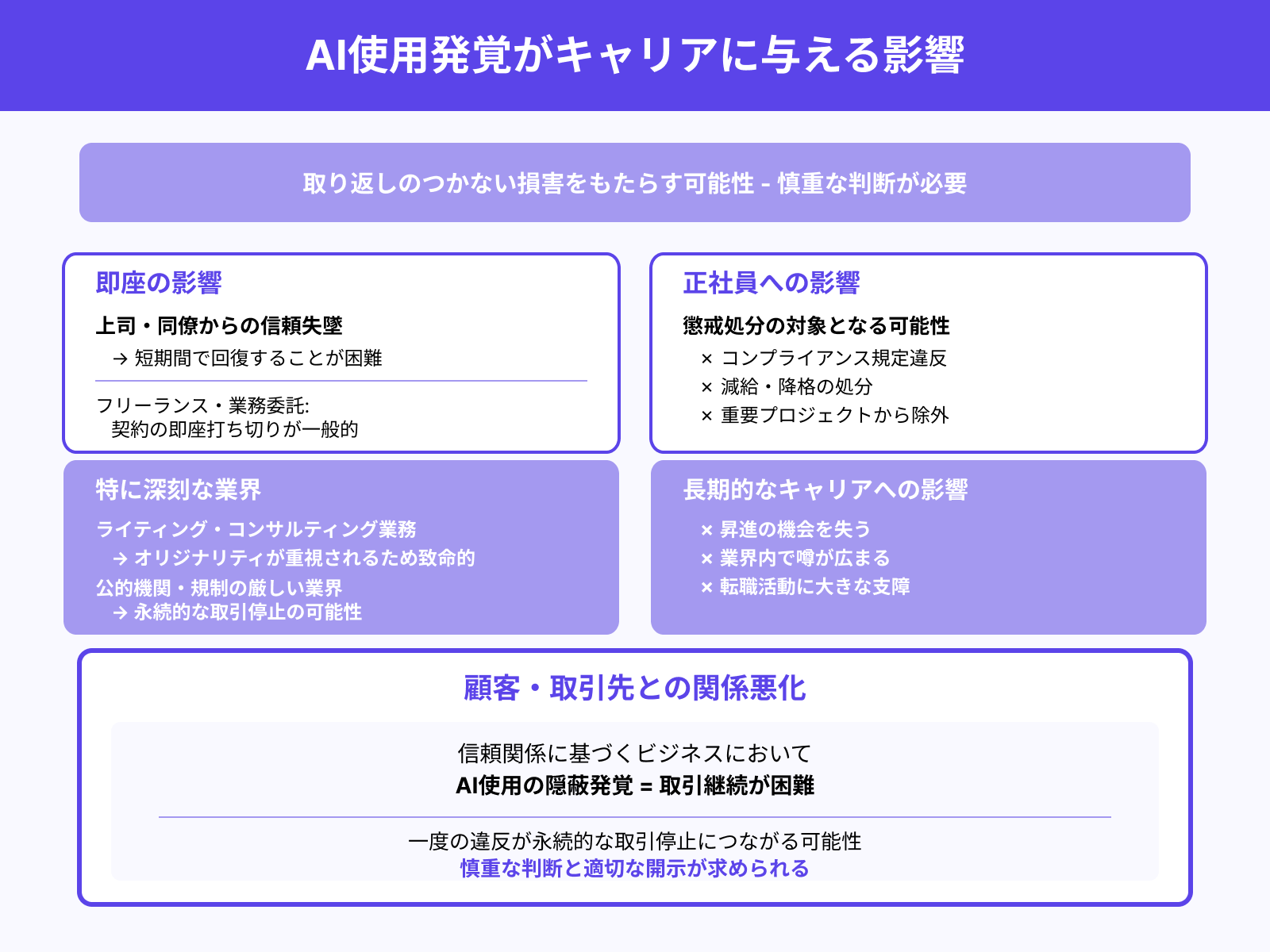

仕事:信頼喪失や契約打ち切りリスク

職場でのChatGPT使用発覚は、キャリアに取り返しのつかない損害をもたらす可能性があります。最も直接的な影響は、上司や同僚からの信頼失墜であり、これは短期間で回復することが困難でしょう。

フリーランスや業務委託の場合、契約の即座打ち切りが一般的な対応となります。特にライティングやコンサルティング業務では、オリジナリティが重視されるため、AI使用の発覚は致命的な問題となるのです。

正社員の場合でも、懲戒処分の対象となる可能性があります。企業のコンプライアンス規定に違反した場合、減給や降格といった処分を受けることもあるでしょう。

長期的なキャリアへの影響も深刻で、昇進の機会を失ったり、重要なプロジェクトから外されたりすることがあります。業界内で噂が広まれば、転職活動にも大きな支障をきたす可能性があるのです。

また、顧客や取引先との関係悪化も避けられません。信頼関係に基づくビジネスにおいて、AI使用の隠蔽が発覚すれば、今後の取引継続は困難になるでしょう。

特に公的機関や規制の厳しい業界では、一度の違反が永続的な取引停止につながる可能性もあり、慎重な判断が求められます。

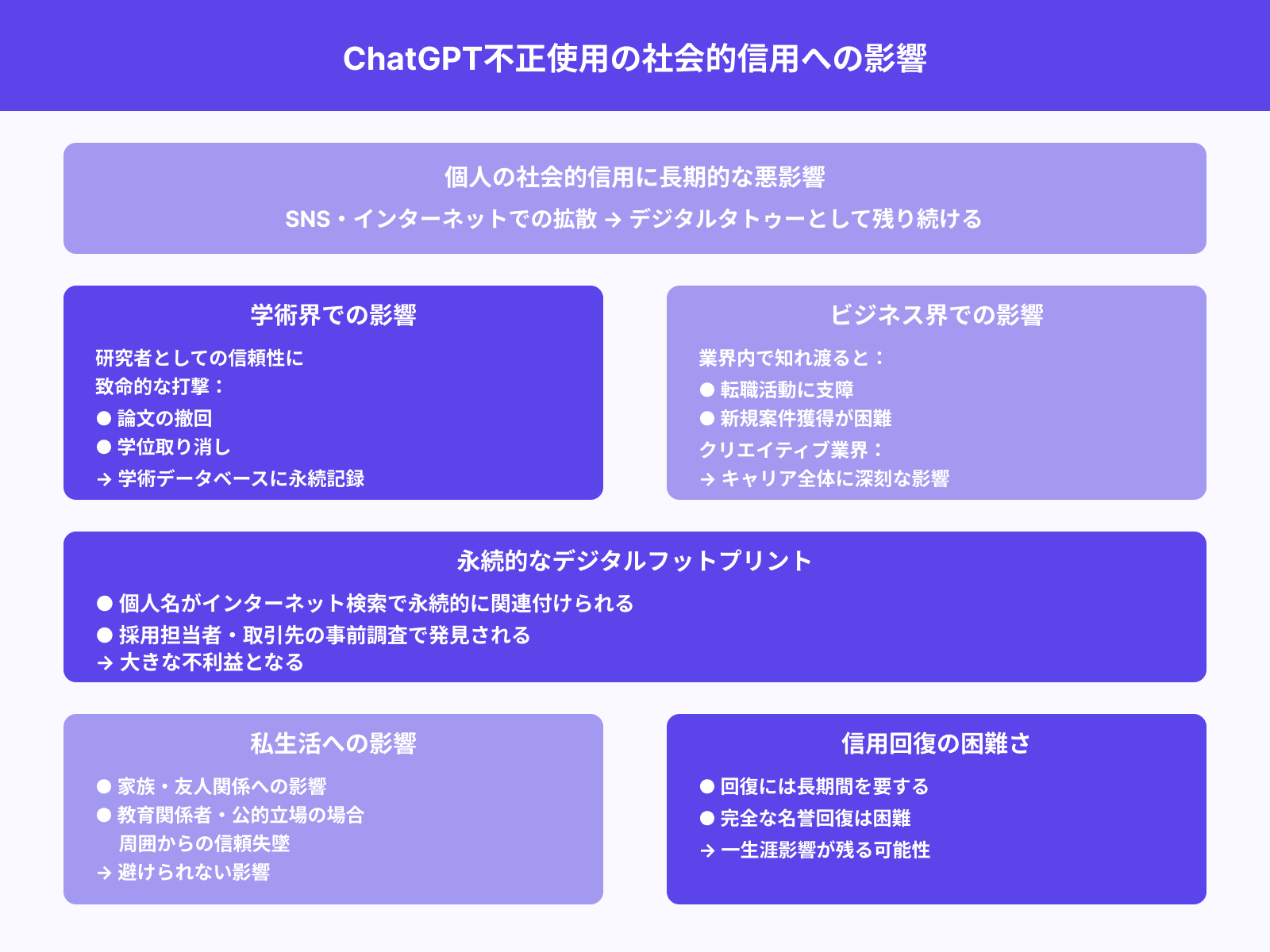

社会的信用の低下につながることも

ChatGPT使用の発覚は、個人の社会的信用に長期的な悪影響を与える可能性があります。特にSNSやインターネット上で情報が拡散された場合、デジタルタトゥーとして残り続けるリスクがあるでしょう。

学術界での発覚は特に深刻で、研究者としての信頼性に致命的な打撃を与えることがあります。論文の撤回や学位取り消しといった処分を受けた場合、その情報は学術データベースに永続的に記録されるのです。

ビジネス界においても、AI使用に関する不正が業界内で知れ渡れば、転職活動や新規案件獲得に支障をきたす可能性があります。特にクリエイティブ業界では、オリジナリティへの信頼が失われることでキャリア全体に深刻な影響が及ぶでしょう。

メディアに取り上げられるような大きな問題となった場合、個人名がインターネット検索で永続的に関連付けられることもあります。

採用担当者や取引先が事前調査を行う際、こうした情報が発見されれば大きな不利益となるはずです。家族や友人関係にも影響が及ぶ可能性があり、特に教育関係者や公的な立場にある人の場合、周囲からの信頼失墜は避けられません。

一度失った信用を回復するには長期間を要し、完全な名誉回復は困難な場合も多いのが現実でしょう。

ChatGPTを活用しながら信頼性を高める方法

ChatGPTを使用しつつも信頼性を維持し、建設的な活用を実現するためには適切なアプローチが必要です。隠蔽するのではなく、透明性と品質向上を両立させることで、より価値の高い成果物を作れるでしょう。

ここからは、責任あるAI活用について以下の観点から詳しく解説します。

それぞれ詳しく解説していきます。

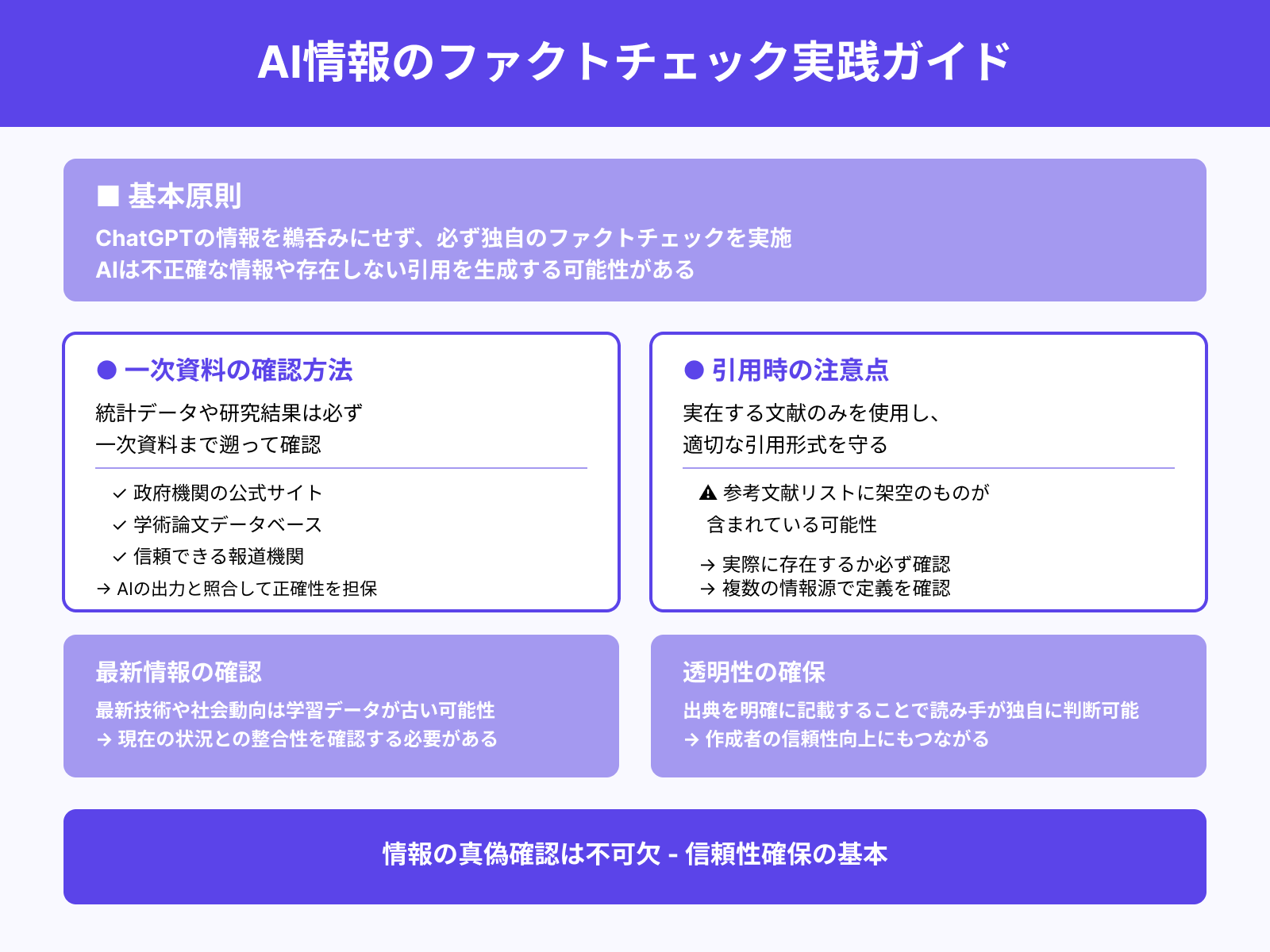

ファクトチェック・出典明記を心がける

ChatGPTが提供する情報を鵜呑みにせず、必ず独自のファクトチェックを実施することが信頼性確保の基本です。AIは時として不正確な情報や存在しない引用を生成することがあるため、情報の真偽確認は不可欠でしょう。

統計データや研究結果については、必ず一次資料まで遡って確認することが重要です。政府機関の公式サイト、学術論文データベース、信頼できる報道機関などから直接情報を取得し、AIの出力と照合することで正確性を担保できます。

引用する際は、実在する文献のみを使用し、適切な引用形式を守ることが大切です。

ChatGPTが提示する参考文献リストは架空のものが含まれている可能性があるため、必ず実際に存在するかどうかを確認しましょう。専門用語や概念についても、複数の信頼できる情報源で定義を確認することをお勧めします。

特に最新の技術や社会動向については、AIの学習データが古い可能性があるため、現在の状況との整合性を確認する必要があるのです。また、出典を明確に記載することで、読み手が情報の信頼性を独自に判断できるようになります。

透明性の高い情報提示は、結果的に作成者の信頼性向上にもつながるでしょう。

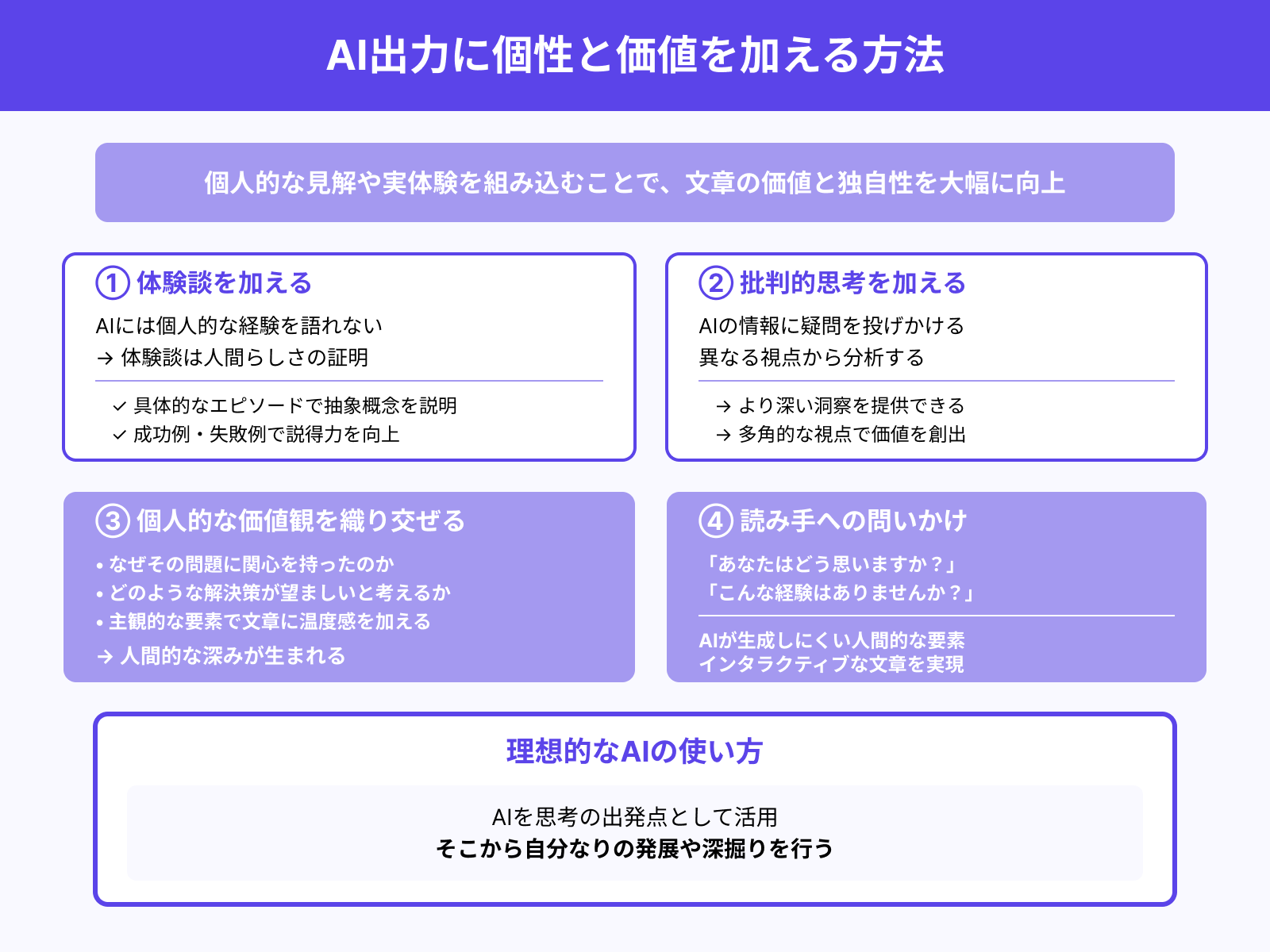

自分の意見や体験談を加える

ChatGPT出力に個人的な見解や実体験を組み込むことで、文章の価値と独自性を大幅に向上させられます。

AIには個人的な経験を語れないため、体験談は人間らしさの証明となるでしょう。具体的なエピソードを交えることで、抽象的な概念を読み手にとって理解しやすい形で説明できます。

たとえば、マーケティング理論について論じる際に、自分が実際に体験した成功例や失敗例を紹介することで説得力が増すのです。

批判的思考も重要な要素となります。AIが提示した情報に対して疑問を投げかけたり、異なる視点から分析したりすることで、より深い洞察を提供できるでしょう。

個人的な価値観や哲学を織り交ぜることも効果的です。

なぜその問題に関心を持ったのか、どのような解決策が望ましいと考えるかなど、主観的な要素を加えることで文章に温度感が生まれます。また、読み手に対する直接的な問いかけを含めることで、インタラクティブな文章にすることも可能です。

「あなたはどう思いますか?」「こんな経験はありませんか?」といった表現は、AIが生成しにくい人間的な要素でしょう。最終的には、AIを思考の出発点として活用し、そこから自分なりの発展や深掘りを行うことが理想的な使い方と言えます。

透明性のある使用表明のメリット

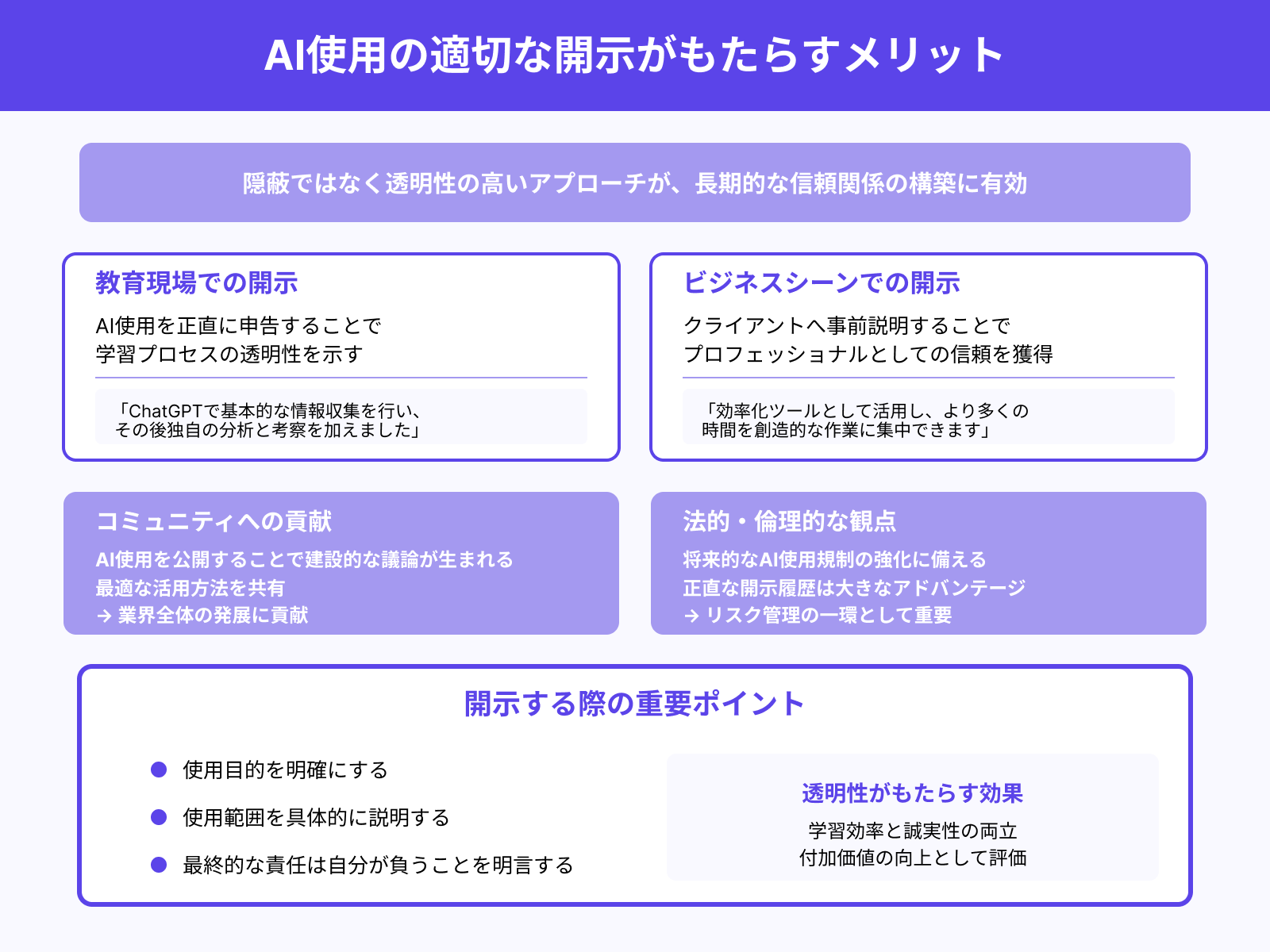

ChatGPT使用を隠蔽するのではなく、適切に開示することで多くのメリットを得られます。透明性の高いアプローチは、長期的な信頼関係の構築において非常に有効でしょう。

教育現場では、AI使用を正直に申告することで学習プロセスの透明性を示せます。「ChatGPTで基本的な情報収集を行い、その後独自の分析と考察を加えました」という形で報告すれば、学習効率と誠実性を両立できるのです。

ビジネスシーンにおいても、クライアントに対してAI活用を事前に説明することで、プロフェッショナルとしての信頼を得られる場合があります。「効率化ツールとして活用し、より多くの時間を創造的な作業に集中できます」という説明は、付加価値の向上として評価される可能性があるでしょう。

また、AI使用を公開することで、同様の課題を抱える他の人々との建設的な議論が生まれることもあります。最適な活用方法やベストプラクティスを共有することで、業界全体の発展に貢献できるかもしれません。

法的・倫理的な観点からも、透明性は重要な要素です。将来的にAI使用に関する規制が強化された場合、正直な開示履歴があることは大きなアドバンテージとなるでしょう。

ただし、開示する際は使用目的や範囲を明確にし、最終的な責任は自分が負うことを明言することが重要です。

まとめ

ChatGPTの使用が発覚するリスクは確実に存在しますが、適切な知識と対策によって大幅に軽減することが可能です。

AI検出ツールの精度向上や教育機関・企業での導入拡大により、従来よりも発覚の可能性は高まっています。特に教育現場や就職活動においては、深刻なペナルティを受ける可能性があるため注意が必要でしょう。

一方で、検出ツールには明確な限界があり、適切なリライトや編集を行うことで検出を回避することは十分に可能です。

重要なのは、AI出力をそのまま使用するのではなく、自分の言葉と混ぜて再編集し、個人的な見解や体験談を加えることです。

最も推奨される活用方法は、透明性を保ちながらAIを効率化ツールとして使用することでしょう。ファクトチェックと出典明記を徹底し、最終的な責任を自分が負う姿勢を示すことで、信頼性の高い成果物を作成できます。

ChatGPTは適切に活用すれば強力な支援ツールとなりますが、倫理的な使用と透明性の確保が長期的な成功の鍵となるのです。