Claudeに学習させない方法は?プライバシーを守る設定を解説

Claudeって勝手に入力内容を学習するの? Claudeは高性能なAIですが、使い方や設定によっては、入力内容が分析や改善に使われる可能性もあります。 Claudeに入力した情報って学習に使われるの? そんな不安を抱えている方も多くいます。 そこでこの記事では、Claudeに「学習させない」ための具体的な方法、プライバシーを守る設定、プロンプトでの伝え方、API利用時の注意点などをわかりやすく解説していきます。 『生成AIに興味はあるけど、どうやって使えばいいんだろう…』 そんな方へ、 を、無料のオンラインセミナーで2時間に凝縮してお伝えします! パソコンはもちろん、スマホから気軽に参加OK。 この2時間が、あなたを変える大きなきっかけになりますよ。 本記事を音声で聴く Claudeを使う際「AIに学習させたくない」という声は多く、特に個人情報や機密データを扱うユーザーにとっては重要な関心事です。 ここからは、Claudeにおける「学習」の定義と、どのような状況でデータが利用されるのかを整理して解説します。 それぞれ詳しく解説していきます。 なお「ClaudeやChatGPTや…生成AIはたくさんありすぎてどれが良いのかわからない…」と悩んでいる人は「生成AIツール診断」をお試しください。 かかる時間は1分ほど。4つの質問に答えるだけで、用途や目的にあう生成AIツールを診断してくれます。 手軽に使う活用する生成AIを選びたい人は、ぜひ一度お試しください。 \ 4つの質問に答えるだけ / Claudeは、Anthropic社が開発するAIモデルで、対話を通じてユーザーの指示に応じた応答を生成します。通常のチャット利用において、入力内容はモデルの改善に使われる可能性があると明記されており、ユーザーが何を入力したかが内部的に記録されることがあります。 ただし、これらのデータは直接的に学習モデルへ反映されるわけではなく、あくまで品質向上のための分析対象となる位置付けです。 Anthropicは「安全性と透明性の確保」を掲げており、データ活用の範囲についても比較的明確に開示しています。設定次第で利用状況を制限でき、学習データへの反映を制御する手段も提供されています。 まずはClaudeの標準的なデータの取り扱い方を理解することが、安全に利用する第一歩です。 Claudeでの入力内容がAIモデルの訓練に使われるかどうかは、利用環境や設定によって異なります。 通常のWebチャットや無料アカウントでは、明示的にオプトアウトしない限り、一部の会話内容が品質向上の目的で収集される設計です。一方、有料プランやビジネス契約においては、デフォルトで学習対象から除外され、より厳格な管理が実施されています。 API経由で利用する場合、送信されたデータは訓練に使われないと明記されており、開発目的での活用にも適しています。 このように「学習に使われるかどうか」の扱いは、利用形態によって変わるため、あらかじめ確認しておくことが重要です。また、実際に機密性のある情報を扱う場合は、明示的な設定変更や契約条件の確認が不可欠です。 AIとやり取りをしていると「記録される=学習される」と思いがちですが、実際にはこの2つは別物です。 Claudeにおける「学習」は、モデル自体の再訓練に使われるプロセスを指しますが「会話履歴の保存」は単にセッションを再利用するための記録です。会話履歴が残っていても、それがそのままモデルの訓練材料になるとは限らず、保存=学習とは一概に言えません。 ユーザーが履歴を管理・削除できる一方で、学習対象に関する選択は別途明示する必要があります。つまり「履歴を削除した=データが学習されない」という誤解を避けることが大切です。 正確な理解を持つことで、より安心してClaudeを活用できるようになります。 Claudeを安心して使うには、最初に「学習させない」ための設定を理解し、正しく対応しておくことが重要です。 ここからは、公式のガイドラインに基づいた基本設定や、プロジェクトモードでの管理方法、セッション単位での伝え方を解説します。 それぞれ詳しく解説していきます。 Anthropic社は、ユーザーのプライバシー保護に関する透明性のある方針を提示しています。 公式サイトには、ユーザーが送信するデータがどのように扱われるか、また学習に利用されたくない場合の対応手順が明記されています。個人利用の場合、設定画面から「フィードバックとしてデータを使用しない」などのオプションをオフにすることで、データ収集を最小限に抑えることが可能です。 また、有料プランではデフォルトでデータが学習に利用されない設定となっており、プライバシー保護が強化されています。法人向け契約では、さらに細かい制御やカスタマイズが可能で、プライバシー条件を契約書レベルで定義することもできます。 まずは、自分の利用状況に応じた設定方法を確認することが第一歩です。 Claudeでは、対話をプロジェクト単位で管理できる「プロジェクトモード」という仕組みがあります。 このモードでは、一つのテーマや目的に沿ったやり取りをまとめて管理できるだけでなく、データの保存と利用に関するポリシーも個別に設定することが可能です。プロジェクト作成時に「この会話は学習に利用しない」と明記すれば、その意図がClaudeの応答方針に影響することもあります。 また、履歴管理のしやすさにより、不要なデータの削除や、使用履歴の明確化も可能です。ビジネス用途で複数メンバーと共有する場合にも、データの整理とプライバシー管理を両立できる手段として有効です。 プロジェクト単位での方針設定を活用することで、安全性と生産性を両立させた運用が可能になります。 Claudeは、明示的なプロンプトによってユーザーの意図を読み取る設計になっています。 そのため、セッションの冒頭で「このやり取りは学習に使わないでください」と入力することで、モデル側に配慮を促せます。このような“意思表示”は、特に無料プランやカジュアルな利用環境で効果的です。 また、文末に「この会話を記録・分析しないでください」と補足を加えるのも一つの手です。完全な制御ではないにしても、ユーザー側のリスク軽減策として活用価値があります。 あわせて、入力する情報の内容自体も精査し、機密性の高い情報は極力避けるよう心がけることが重要です。 Claudeを安心して利用するためには、送信したデータがどのように処理され、保持されるのかを理解することが不可欠です。 ここからは、Anthropic社のプライバシーポリシー、Claudeが保持するデータの範囲、ビジネス利用時の対応について解説します。 それぞれ詳しく解説していきます。 Anthropic社は、ユーザーデータの取り扱いについて比較的明確な方針を公表しています。 同社のプライバシーポリシーでは、収集する情報の種類、利用目的、保存期間、第三者との共有条件が具体的に示されています。特に注目すべきは「ユーザーの明示的な許可がない限り、個人を特定可能な情報を学習データとして活用しない」という姿勢です。 また、法人ユーザーに対しては、契約ベースでより厳密な取り扱いルールが適用され、データ保持や削除のタイミングも調整可能となっています。個人利用であっても、オプトアウトの方法が用意されており、自分の情報がどのように扱われるかをある程度コントロールできます。 公式のプライバシー文書は更新されることがあるため、定期的に確認する習慣も大切です。 Claudeで送信されたデータは、一時的にサーバー上に保存されることがありますが、これは品質向上や不正検出などの目的に限定されています。 ただし、保存された情報がすべて学習に使われるわけではなく、多くの場合は匿名化・集約された形式で分析されます。有料プランやAPI経由の利用では、初期設定で学習対象外とされており、保持期間も限定される仕組みです。 また、ユーザーが削除した履歴は一定期間を経て完全に消去され、管理者からの削除依頼にも対応可能となっています。ただし、一部のログ情報(リクエスト履歴や使用統計など)は、技術的・法的理由で一定期間保持されることがある点には注意が必要です。 保持データの種類や保存期間は利用環境によって異なるため、利用前に必ず確認しておきましょう。 企業や団体でClaudeを活用する際は、社内のセキュリティポリシーや法令遵守(コンプライアンス)に基づいた運用が求められます。 Anthropicはエンタープライズ契約において、GDPRやCCPAなどの国際的なプライバシー規制に対応した条件での運用が可能です。業務データや顧客情報を取り扱う場合には、契約上での「データの非学習」「保存期間の指定」「第三者提供の制限」などの取り決めが重要になります。 また、企業内でClaudeを利用する場合は、アクセス権の管理、APIキーの厳格な取り扱い、ログ管理体制の構築も併せて実施すべきです。セキュリティ部門や法務部との連携を図りながら、内部規定に合致した形での導入を進めると安全です。 信頼性の高いAI活用には、技術だけでなく運用体制と管理ルールの整備も欠かせません。 AIを業務に活用する際、最も気になるのが「機密情報を入力しても安全かどうか」という点です。 ここからは、Claudeに個人情報や社内情報を入力する際のリスクと、それを回避するための実践的な注意点を紹介します。 それぞれ詳しく解説していきます。 Claudeは高いセキュリティ設計を持っていますが、個人情報や社内の機密情報をそのまま入力するのは推奨されません。特に名前、住所、社員番号、顧客データ、契約内容などの具体的な情報は、万が一の漏洩リスクに備えて慎重に扱う必要があります。 Claudeに入力されたデータは、一時的にクラウド上に保存・分析される可能性があるため、意図せず保存対象となるリスクもあります。安全性を確保するためには、情報をマスキングしたり仮名に置き換えたりといった処理を行ったうえで相談・質問を行うのが基本です。 重要な情報はAIではなく社内関係者と共有するようにルール化することで、さらに安全性を高められます。Claudeといった生成AIの情報漏洩事例を詳しく知りたい人は、次の記事を参考にしてください。 高い秘匿性が求められる情報をClaudeに入力する際には、事前にリスクと対策を明確にしておく必要があります。 たとえば、新製品の仕様、未公開の提案資料、顧客戦略といった情報は、AIにそのまま渡さず、要約・抽象化して伝えるのが安全です。また、必要に応じて「この会話は学習に使わないでください」と明記することで、AI側に配慮を促すことも有効と言えます。 API経由で使用する場合は、エンドツーエンドでの暗号化設定やログ制御など、システムレベルでの保護も重要です。機密情報を入力する前に「本当にAIに伝える必要があるのか」を一度立ち止まって考えることも、リスク回避につながります。 Claudeを使う上で、情報漏洩を防ぐための基本的な「使い方のルール」をあらかじめ決めておくことが重要です。 安全に使うポイントは「入力前に精査」「プロンプトに配慮」「履歴の削除」「セキュリティ設定の確認」の4つが基本です。 まず、入力内容を第三者に見られても問題ない形に整えたうえで、質問や指示を行うこと。次に「この情報は記録しないでください」などのプロンプトで意図を示すことも効果的です。 履歴が保存される前提で使うなら、不要なチャットは手動で削除しておくと安心です。さらに、プランや環境に応じたセキュリティ設定を見直すことで、全体の安全性を高められます。 Claudeの安全性を詳しく知りたい人は、次の記事を参考にしてください。 AIを安全かつ安心して使うには、各サービスが「ユーザーデータをどう扱うか」を知っておくことが重要です。 ここからは、ClaudeとChatGPTのデータ利用方針・オプトアウト設定の違い、ビジネスユースの観点でどちらが安心かを比較して解説します。 それぞれ詳しく解説していきます。 Claudeを提供するAnthropicと、ChatGPTを提供するOpenAIでは、ユーザーデータの取り扱い方針に明確な違いがあります。 Claudeは「ユーザーの同意がない限り、データを訓練に使用しない」ことを原則として掲げており、特に法人利用においては非学習設定がデフォルトです。一方、ChatGPT(無料・Plusプラン)は、オプトアウトしない限り、やり取りの内容が今後のモデル改善に活用される可能性があります。 OpenAIは透明性のある方針を掲げており、設定で制限をかけることは可能ですが、デフォルトでの違いは理解しておくべきポイントです。セキュリティやプライバシー重視の場面では、この基本方針の違いが導入判断に大きく影響します。 ClaudeとChatGPTの両者とも、ユーザーが「学習させない」設定を選ぶことが可能です。ただし、設定の初期状態や変更方法には違いがあり、利用者側が意識して確認・操作する必要があります。 Claudeでは、無料プランでも設定画面から明示的に「データを学習に使わないようにする」オプションをオフにすることが可能です。有料プランやエンタープライズ契約では、デフォルトで非学習設定となっていることが多く、安心して利用できます。 一方、ChatGPTは、設定画面から「会話履歴とトレーニングを無効化」することでオプトアウトが可能ですが、履歴を無効にすると過去のチャットも参照できなくなる仕様です。 このように、制限のかけ方とその影響範囲にも違いがあるため、目的や使い方に合った選択が求められます。 ビジネス利用において重要なのは「安心して機密情報を扱える環境かどうか」です。 その点で言えば、Claudeはエンタープライズ向けに非学習・高セキュリティを前提とした構成が整っており、企業利用に適しています。API利用時も、Claudeではユーザーデータがトレーニングに使用されないと明記されており、ログの保持も最小限に抑えられる傾向があります。 ChatGPTもBusinessプランやEnterpriseプランでは同様に非学習設定が可能ですが、無料・Plusユーザーでは学習が前提の運用が基本です。業務や顧客情報を扱う場合には、プランの選定や契約条件の確認が特に重要です。 両者ともに対応策はあるものの、最初から非学習を前提としたClaudeの方が導入時の安心感は高いと言えるでしょう。 ClaudeをAPIで活用する際には、学習への影響やセキュリティについての理解がより重要になります。 ここからは、API経由でのデータ取り扱い方針、オプトアウトの方法、セキュリティ設計のベストプラクティスを紹介します。 それぞれ詳しく解説していきます。 ClaudeのAPIを使う場合、最も気になるのが「送信したデータが学習に使われるのかどうか」という点です。 Anthropicは公式に「API経由で送信されたデータはモデルの学習には使用されない」と明言しており、セキュリティ面での安心感が高い仕様です。このポリシーにより、開発者や企業が自社データを活用しても、その情報がAIモデルに蓄積・再利用されることはありません。 ただし、ログ情報やエラーレポートは品質向上のために内部的に参照される場合がありますが、個人情報が学習対象になることは基本的にありません。API経由のやり取りは、他のチャット形式と比べて、プライバシー管理が徹底されていると言えるでしょう。 この仕様を理解することで、安心してアプリケーションにClaudeを組み込める環境が整います。 API利用時にさらに安心感を得たい場合は「このデータは学習に使わないでほしい」という意思表示を行うことも可能です。 Anthropicは、商用・法人利用において、契約時にオプトアウトの意向を明示することを正式に受け入れており、条件に応じた非学習設定が反映されます。エンタープライズ契約では、明文化された合意のもと、送信データの完全な非保持や暗号化対応を含めた個別対応が可能です。 一方、個人または開発者アカウントでの利用時は、プライバシーポリシーに従い、一般的に学習対象外とされています。念のため、APIリクエストの中で「このデータは記録・学習に使わないでください」と記述することで、補足的な配慮も加えられます。 重要な情報を扱う前に、API利用規約と開発ドキュメントを確認し、明示的なポリシー設定を徹底しておきましょう。 Claude APIをシステムに組み込む際は、機能面だけでなくセキュリティ設計も意識することが不可欠です。 特に、APIキーの厳重管理、通信のHTTPS化、トークン制限、ログのマスキングなどは、最小限のセキュリティ対策として必須です。また、入力されるデータに個人情報や機密が含まれる場合は、サーバーサイドでの事前フィルタリングや暗号化処理を取り入れることでリスクを大幅に軽減できます。 APIのレスポンスデータを保存・共有する際にも、誰がアクセスできるのかを明確に管理し、権限の分離を徹底することが重要です。企業やサービス提供者側では、社内ルールやコンプライアンスと整合した運用ルールを構築しておくと、万が一のトラブル時にも対応しやすくなります。 Claude APIは柔軟性が高いからこそ、セキュリティ対策をしっかり講じることで、その信頼性をさらに高められます。上記を踏まえ、Claude APIの特徴をより詳しく知りたい人は次の記事を参考にしてください。 Claudeをより安全に使うには、プロンプトの書き方にも配慮が必要です。 ここからは、学習回避やデータ記録の防止につながる表現方法や、注意書きとして使えるテンプレートを紹介します。 それぞれ詳しく解説していきます。 Claudeは、プロンプトに含まれる明示的な意図を読み取るよう設計されています。 そのため「この会話の内容はモデルの学習や分析に使わないでください」といった表現を冒頭に入れることで、意図をAI側に伝えることが可能です。この一文を付け加えるだけでも、AIが出力内容を調整したり、記録の扱いをより慎重に行う傾向があります。さらに「このやり取りは個人利用目的です」「機密情報を含んでいます」と補足することで、リスクを意識したやり取りに誘導可能です。 絶対的な保証にはならないものの、ユーザーとしての姿勢を明確に示すことで、データ利用に対する制御効果が期待できます。 Claudeを使う際に、ログへの記録や履歴保存を避けたい場面もあるでしょう。 その場合は「この情報は一時的に処理するだけで保存しないでください」といった指示をプロンプトに組み込むのが有効です。また「個人情報は含まれていません」「一時的なタスクのための入力です」など、明確に意図を補足することで、AI側の挙動も慎重になります。 さらに、プロンプトの構成としても、具体的な名前や数値を避け、仮の情報に置き換えることで実質的なリスクを低減できます。開発者向けには、プロンプトテンプレートとして「非保存」や「非学習」の一文を標準化しておくと安心です。 会話の前提として「記録しない」「分析しない」を明示することが、プロンプト設計の第一歩になります。 Claudeを安全に使うためには、ユーザー側からの“明示的な一言”が鍵です。以下のようなテンプレートをあらかじめ用意し、必要な場面で使い回すことで、毎回の対話をより安心なものにできます。 たとえば「この会話の内容は保存・学習に使用しないでください。機密情報を含んでいる可能性があります。」という文を冒頭に入れるだけでも効果があります。他にも「この入力内容は一時的な処理用です。記録・分析の対象としないでください。」などの表現も有効です。また、開発中のプロジェクトでは「プロンプトの中にこのテンプレートを含めること」をルール化するのもおすすめです。 テンプレート化することで、個人だけでなくチーム全体で安全意識を共有しやすくなります。 上記を含め、Claudeでの回答精度を高めるプロンプトの作成方法を詳しく知りたい人は、次の記事を参考にしてください。 Claudeを活用する際「学習させたくない」「データを記録されたくない」という不安を抱えるユーザーは少なくありません。 しかし、設定や使い方を工夫することで、Claudeをより安全・安心に活用することが可能です。学習と会話履歴の違いや、利用プランごとのポリシー、プロンプトでの意思表示など、意識すべきポイントを押さえればリスクは最小限に抑えられます。また、API経由の利用やビジネス用途では、契約レベルでのオプトアウト対応やセキュリティ設計の工夫も有効です。 重要なのは、Claudeの設計思想やAnthropic社のポリシーを正しく理解し、自分の用途に応じた使い方を選ぶことです。この記事を参考に、機密情報の取り扱いや安全なプロンプト設計を心がけながら、Claudeを信頼できるツールとして賢く活用していきましょう。

Claudeに機密情報を入れても大丈夫なのか不安なんだけど…

Claudeに学習させたくないときって、どうやって設定すればいいの?

機密情報を入力しても大丈夫?

参加者には限定で「生成AI活用に役立つ7大特典」をプレゼント中🎁

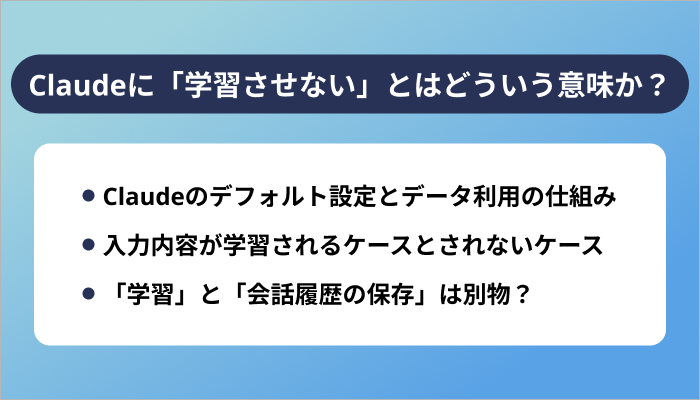

Claudeに「学習させない」とはどういう意味か?

Claudeのデフォルト設定とデータ利用の仕組み

入力内容が学習されるケースとされないケース

「学習」と「会話履歴の保存」は別物?

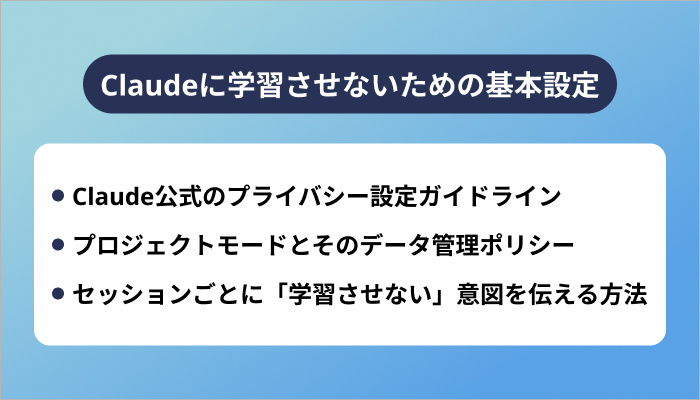

Claudeに学習させないための基本設定

Claude公式のプライバシー設定ガイドライン

プロジェクトモードとそのデータ管理ポリシー

セッションごとに「学習させない」意図を伝える方法

Claudeにおけるデータの扱いとポリシー

Anthropicのプライバシーポリシーの要点

Claudeはユーザーデータをどこまで保持する?

ビジネス利用時のコンプライアンス対応

Claudeに機密情報を入力する際の注意点

個人情報・社内情報を入力しても大丈夫?

機密性の高い内容はどう取り扱うべきか

Claudeでの「安全な使い方」のポイント

ClaudeとChatGPTの学習ポリシーの違い

ClaudeとOpenAIのデータ使用方針の比較

両者の「学習オプトアウト」設定の違い

ビジネスユースで安心なのはどっち?

Claude API利用時の学習とプライバシー設定

API経由のデータは学習対象になるのか?

オプトアウトの明示方法と設定方法

Claude APIとセキュリティ設計のベストプラクティス

Claudeを安全に使うためのプロンプト例

「この会話は学習に使わないでください」の伝え方

データの記録を防ぐプロンプト設計

ユーザーが明示すべき注意書きのテンプレート

まとめ